Wie zuverlässig sind die Daten der Google SearchConsole!?

Die Google SearchConsole ist war für Webmaster ein sehr hilfreiches Tool. Denn hier bekommt man Daten, die man sonst nirgendwo findet. Vor allem der Leistungsbereicht bot eine Fülle wertvoller Daten über die Positionen einzelner Keywords und die Klicks, die man darüber erhält. Immer mehr Seo-Tool-Anbieter bieten inzwischen die Möglichkeit, diese Daten der SearchConsole zu importieren und das Seo-Business daran auszurichten. Aber wie zuverlässig sind diese Daten überhaupt? Ich hege inzwischen gravierende Zweifel, ob diese Daten überhaupt noch etwas mit der aktuellen Realität zu tun haben.

Über die neue SearchConsole wird viel gemeckert. Zurecht, wie ich finde. Aber es handelt sich bislang weitgehend um Usability- Probleme. Da werden plötzlich mal 12.000 statt den tatsächlichen 300 Seiten angezeigt, die Links sind nicht sortierbar und und und. Aber bislang gab es ja dieses Grundvertrauen, dass Google schon echte validen aus der Suche als Grundlage benutzt. Als Webmaster ist man gezwungen, darauf zu vertrauen, dass das auch stimmt.

Nach meinen Ranking-Verlusten im Zuge des letzten Google Core Updates analysiere ich natürlich viel. Dabei schaue ich mir auch regelmäßig die Daten in der SeachConsole an – und seit dem Update vor ca. drei Wochen kann ich nur sagen: das passt vorne und hinten nicht mehr.

Konkretes Beispiel

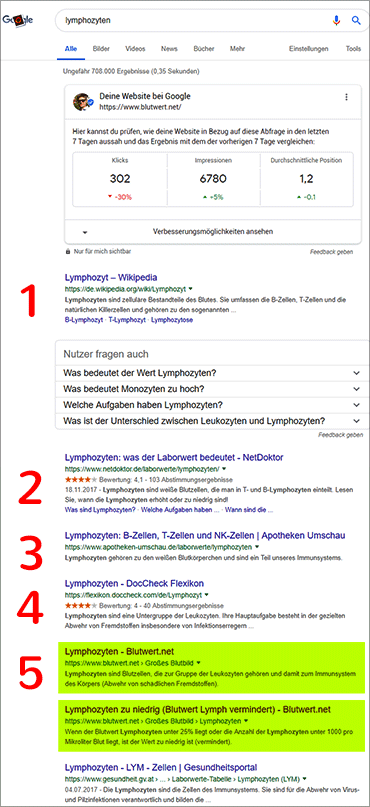

Vor dem Update war ich für das Keyword „Lymphozyten“ mehrere Wochen / Monate auf Position 1-2 in den Google Suchergebnissen zu finden. Leider bin ich nach dem Update auf Position 7-8 abgefallen, inzwischen liege ich wieder auf Position 5-6. Woher ich das weiß? Ich prüfe das täglich, manuell am Rechner und am Handy.

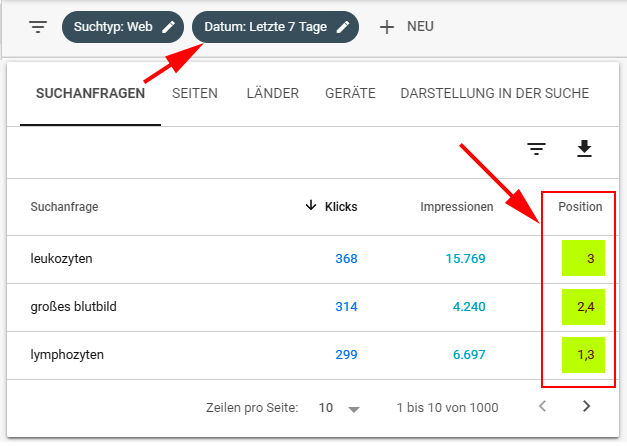

Daher weiß ich, dass ich in den letzten 7 Tagen bestenfalls auf Position 5 war, meist eher auf Pos. 6 oder 7. Und was sagt mir nun die SearchConsole? Hier der Screenshot:

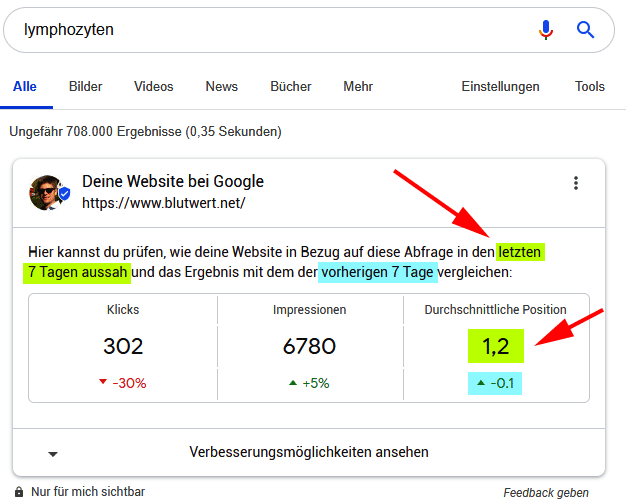

Google zeigt mir an, dass ich für „Lymphozyten“ auf Pos. „1,3“ stehen würde. Ein Blick in die Suche selber (im eingeloggten Zustand) liefert mir folgenden Screen:

Und was zeigt sich darunter? Die echten Suchergebnisse. Da erkennt man deutlich, dass meine Seite aktuell nur auf Pos. 5 steht – was die beste Platzierung der letzten drei Wochen ist.

Wie kann das sein!?

Offensichtlich gibt es hier eine erhebliche Diskrepanz. Und das ist kein Einzelfall, sondern zieht sich durch fast alle meine SearchConsole-Daten. Durch die Bank weg werden mir viel bessere Positionen angezeigt. In dem Screen oben sieht man noch das Keyword „leukozyten“, wo ich laut SerachConsole auf Pos. 3 stehen würde (in den vergangenen 7 Tagen). In der Realität stehe ich aber nur auf Position 9-11. Mit „großes Blutbild“ – laut Google auf Pos. 2,4 – bin ich effektiv seit 3 Wochen nur auf Pos. 4 oder 5. Und so weiter …

Die SearchConsole-Daten scheinen noch aus der Zeit vor dem Core-Update zu stammen (!). Dann würde es passen.

Womit sich die grundlegende Frage stellt: inwiefern kann man den Daten aus der Google SearchConsole überhaupt vertrauen? Sind das zufällige, irgendwann mal erhobene Daten? Kann man daraus irgendetwas ableiten?

Wie oben bereits gesagt: natürlich sind das nur stichprobenartige Einzelfälle – ich kann ja nicht hunderte von Rankingpositionen täglich überprüfen. Die Daten der Toolanbieter sind da wesentlich näher an der Realität, auch wenn man natürlich bedenken muss, dass sie nur ein begrenztes Keyword-Set abbilden können und dass sie tägliche Schwankungen auch nur relativ grob erfassen können. Aber offensichtlich sind die Toolanbieter-Daten deutlich valider als die der Google SearchConsole.

Wie sieht es bei Euch aus? Habt ihr ähnliche Beobachtungen gemacht? Bei mir fällt es jetzt ja im Grunde nur deshalb auf, weil ich in kurzer Zeit massive an Rankingpositionen verloren habe – sonst hätte ich das vermutlich nie bemerkt.

Btw: die Klickzahlen aus der SearchConsole scheinen (!?) einigermaßen realistisch zu sein. Aber aus der Kombination aus Klickzahlen und Rankingposition ergeben sich z.B. völlig falsche Werte (CTR).

20 Gedanken zu „Wie zuverlässig sind die Daten der Google SearchConsole!?“

Hier mal die Lösung für Deine Lymphozyten!

Die Daten sind zwar richtig, aber eben ohne den Hinweis, dass das Bild in der Pos0 Box zählt, total sinnfrei.

Hatte ich letzten bei einem Kunden gesehen. Wir sind plötzlich von 7-8 auf 1,2 gesprungen und hatten misserable Klickzahlen. Dadurch ist es mir aufgefallen.

super Hinweis, danke. Und mir ist dabei eben aufgefallen, dass man im eingeloggten Zustand die Bilder (Knowledge-Graphp) gar nicht sieht, weil da nämlich diese (o.g.) SearchConsole-Daten angezeigt werden. Dann wird das Knowledge-Graph-Bild verschluckt.

Mich treibt derzeit die „Nutzerfreundlichkeit auf Mobilgeräten“ in den Wahnsinn. Täglich grüßt mit Google mit einer Email, dass neue Fehler aufgetaucht sind. Mittlerweile > 4.000 Seiten als fehlerhaft markiert, wegen „Anklickbare Elemente liegen zu dicht beieinander“ oder „Text ist zu klein zum Lesen“. Wenn ich dann die URL direkt prüfen lasse, kein Problem, alles in Ordnung.

Wir unterwerfen uns hier einem Diktat, dass mir immer mehr widerstrebt.

Hallo,

„Die Seite ist nicht für Mobilgeräte optimiert“ (Text zu klein; zu dicht nebeneinander) wird bei mir bei sehr vielen Seiten bei der neuen Search Console in der Rubrik Verbesserungen angezeigt. Das seit ca. Mitte März. Vorher erschien für die Seiten kein Problem mit mobilen Seiten. Beim Testen mit Live URL erscheint allerdings „Die Seite ist für Mobilgeräte optimiert.“

Es gibt noch was, das auch mir Probleme bereitet. Die Daten in der GSC sind immer noch wenn man das Datum auf benutzerdefiniert stellt erst mit einer Verzögerung von 3 Tagen abrufbar.

Stellt sich für mich die Frage: Welche Daten nimmt Google wenn man „letzten 7 Tage“ einstellt? Heute-3, also tag -10 bis -3? Oder doch die letzten 7, aber nur Tag -7 bis -3 (was nur 4 Tage wären)? Und falls zweite Lösung – sampelt Google dann auf 7 Tage wie in Analytics oder was?

Weiß das einer? Wenn nicht prüfe ich das die Tage mal. Lässt sich ja relativ leicht checken.

An dem Datenpunkt steht doch welches Datum du hast.

Folgendes habe ich dazu…

ich nutze derzeit drei große SEO-Tools, die alle Keywords täglich crawlen. Alle drei Tools zeigen mir jeden Tag völlig unterschiedliche Rankings an. Kommt auf die Zeiten an, in denen sie crawlen? Könnte sein, es könnte aber eben auch sein, dass Google noch mehr personalisiert und RankBrain Ergebnisse aktiv umsortieren lässt. Deshalb kommt jedes Tool zu anderen Rankings und deshalb wechseln die Rankings auch ständig.

Das ist meine aktuelle Theorie. Aber wie alle zurzeit, ist sie sehr brüchig.

Seit Ende 2018, wo das mit den komischen Updates anfing, gibt es bei vielen meiner Kunden einfach keine Stabilität mehr. Seit Monaten beobachte ich händisch und mit den erwähnten Tools die Rankings. Und es gibt einfach dauernd wechselnde Plätze. Ein richtiger Google Dance eben. Heute auf 4, morgen auf 7, dann wieder auf 3 und plötzlich zurück auf 15. Absolut ohne sichtbaren Grund und auch bei klar überlegenen Seiten.

Mir geht es einfach nur noch hart auf die Nerven. Darunter sind halt Seiten, die wirklich gut sind und alles richtig machen und vor dem Update auf Platz 1 standen, jetzt aber aus irgendeinem Grund hinter minderwertigen Seiten landen. Kann ich nach wie vor nicht nachvollziehen.

Zu der Search Console… was Google sagt, habe ich denen noch nie geglaubt. Die Search Console nutzen sie meiner Meinung nach, um Zusammenhänge zu erkennen. Die Daten selbst erschienen mir noch nie logisch und daher habe ich sie auch nie sonderlich beachtet. Dazu rate ich auch. Genau wie man auf Aussagen von Google nichts geben sollte, da dort anscheinend eh kaum jemand weiß, wie das alles wirklich funktioniert.

Außerdem sollte man immer zusätzlich die Filter „Land“ auf z.B. Deutschland und den Filter „Suchanfrage“ z.B. ohne Brand einstellen. Außerdem kommt halt noch Personalisierung und Historie dazu. Das kann schon durchaus sein, dass es bei dem einen auf 2 steht und bei anderen auf 5 steht.

Martin,

ich würde an deiner Stelle das mit den 2 Beiträgen überdenken (Keyword-Kannibalisierung), wenn die zwei Seiten über einen längeren Zeitraum ranken sollten.

Grüße

Wenn man ein Google-My-Business Account hat werden die Console Ergebnisse auch einbezogen, meiner Meinung nach – und so wird der Local Search in die Google Console miteinbezogen. Es kann daher sein, dass ein man ein locales Ranking , Position 1, hat, aber auf Google in der organischen Suche gar nicht oder irgendwo hinten aufscheint.

Generell werden Platzierungen als Durchschnitt aller Standorte geführt, IMHO.

Ein Bekannter von mir arbeitet in Softwarebranche. Kleines Unternehmen, aber alte Software (bereits seit 20 Jahren in der Entwicklung und beständig weiterentwickelt). Der erzählt mir dann auch immer Geschichten, dass die Software irgendwann so komplex geworden ist und wenig (Code-)Dokumentation vorhanden.

Warum sollte das bei Google anders sein? Da werden auch noch Codeschnipsel vor sich hingammeln, die man nicht entfernen kann, ohne dass das Ganze wie ein Kartenhaus zusammenbricht.

Und das können solche Seiteneffekte sein.

Google kocht halt auch nur mit Wasser.

Aber gut zu wissen, dachte bisher gerade die eigenen Tools von Google seien zuverlässig, aber da werde ich wohl auch lieber noch mal mit anderen Tools gegenprüfen.

Mir geht es genauso, wobei es bei mir ungedreht ist und meine Seite in den Suchergebnissen besser Rankt als in der GSC angegeben, das ist zwar positiv heißt aber trotzdem das die Ergebnisse nicht das tatsächliche ranking wiederspiegeln. ich selber Teste meine Suchergebnisse auch relativ regelmäßig zwei bis 3 mal die Woche, in wieweit die Google my Business Daten da mit einspielen würde mich auch mal interessieren. Ich habe neulich einen Artikel in einem SEO Blog gelesen das man bei häufigen Suchanfragen zum Beispiel für die eigene Seite diesen Code nutzen kann … Neuer URL Parameter „no_sw_cr“ zeigt frische Suchergebnisse… um dann zumindest nicht alte Cacheabfragen zu bekommen. Vielleicht ist das ja für dich zu Testzwecken auch interessant.

Gruß Tim

Hi Marin,

entschuldige die Frage eines Anfängers. Aber kann es sein, dass die Position meiner Seite in den Suchergebnissen eine andere ist, wenn ich im Google-Konto bzw. bei Chrome eingeloggt bin, als würde ich das selbe Keyword im Inkognito-Modus suchen?

Vielen Dank,

Moritz

Guter Artikel! Ich hatte ganz ähnliche Erfahrungen gemacht. Danke auch an die die vielen hilfreichen Kommentatoren!

Hallo Martin,

wollte nur mal nachfragen wie das neue Google Update bei dir aufgenommen wurde?

Ich mochte die alte Version lieber. Man konnte auch noch direkt einzelne Urls einreichen. Die neue ist aufgeräumter, aber irgendwie flach. Naja, ich fand die Oldschool-Version besser als Advanced User. Für Basisnutzer ist die neue Version leichter.

Bei mir stimmen die Zahlen nicht, Google übertreibt da etwas zu viel.

Tatsächlich kommt es auf alten/bestehenden Seiten häufiger zu Crawlingfehlern. Auf neuen Seiten sind diese mit ein wenig Planung und den richtigen Schwerpunkten jedoch gut zu vermeiden.

Einfach streng bei der Erstellung nach dem mobile first Ansatz gehen und immer wieder mit PageSpeed Insights beim erstellen schon checken. Ebenfalls ständig auf echten, also nicht simulierten Geräten die Usability checken. Über die Lebensdauer der Seite immer wieder iVm der search console rechecken.

Persönlich fahre ich mit der Strategie ziemlich gut soweit :)

Die Kommentare sind geschlossen.