Negative Rankingfaktoren, Prinzip der „kritischen Hürde“

Content is King ist out – soviel ist klar. Genauer gesagt: Content reicht nicht, es muss guter Content sein. Aber was ist guter Content? Julian hat dazu einen Blogpost geschrieben: „Hast du qualitativ hochwertigen Content?„. Der Artikel mündet in den Fragen „Habe ich Platz 1 verdient? Was macht mein Mitbewerber, was ich nicht mache?„. Ich finde das sehr interessant (im Ansatz arbeite ich genauso), allerdings aus Seo-Sicht doch etwas zu kurz gedacht. Daher hier meine Antwort auf den Artikel.

Wer Suchmaschinenoptimierung betreibt, darf sich letztlich nicht fragen, was man selber für den besten Content zu einem Thema / Keyword hält, sondern was wohl eine Suchmaschine dazu meint. Und genau dieses „…dazu meint“ möchte ich mal versuchen weiter aufzudröseln (man könnte auch fragen: Wie funktioniert der Google-Algorithmus? :-) )

Rankingsignale: Je mehr, desto besser?

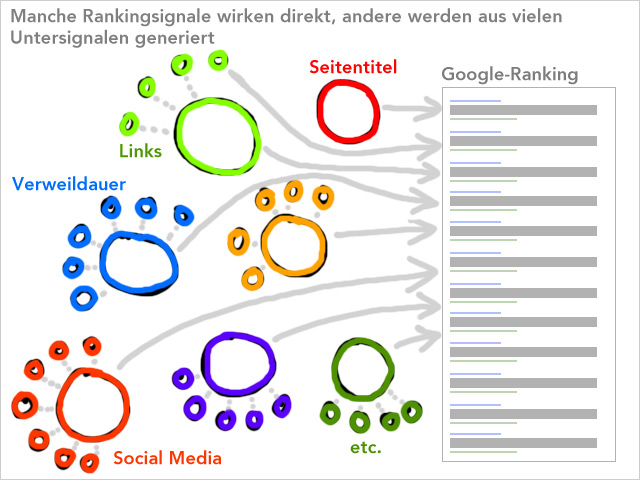

Es gibt eine Reihe von „Rankingfaktoren“, so viel ist klar. Ob es 200 oder 500 oder 1.000 sind, halte ich zunächst einmal für völlig irrelevant. Denn wer eine Zeit lang SEO betrieben hat, wird mir zustimmen: entscheidend sind letztlich vielleicht 20 oder 30. Genauer gesagt: zur Zeit. Klar ist nämlich auch, dass sich die Gewichtung der Rankingfaktoren verändert. Die einzelnen Faktoren wirken wie Stellschrauben. Die Frage ist: wie wirken sie zusammen? Die einfachste Möglichkeit ist: es wird einfach alles addiert. Anders gesagt: je mehr Rankingsignale eine Website hat, um so höher steigt sie im Ranking.

Wenn ich das jetzt so schreibe, wird klar, dass es so natürlich nicht funktioniert. Je mehr, desto besser ist eben kein plausibles Qualitätsmodell. Guter Content ist nicht (nur) eine Frage der Quantität. Aber was dann?

Positive Rankingsignale

Es gibt eindeutig Ranking-Signale, die sich positiv auf das Ranking auswirken. Dazu gehört zweifelslos der Seitentitel. Wenn man eine Seite mit einem guten Ranking hat, und dann das keyword aus dem Titel entfernt, rutscht die Seite signifikant nach unten. Beim Titel wirkt das Prinzip „ja oder nein„, bzw. „vorhanden oder nicht vorhanden“.

Mit den eingehenden Links verhält es sich etwas anders. Nach meiner Beobachtung hat ein Link deutlich weniger Einfluss als das Keyword im Seitentitel. Hat eine Seite erst einmal eine Position unter den Top20, dann kann ein einfacher Blogkommentar, egal ob follow oder nicht, nichts am Ranking verändern. Ein sehr guter Link, zum Beispiel aus Wikipedia oder dmoz, kann eine Positionsverbesserung um 3 – 5 Plätze bringen. Aber mehr auch nicht. Hundert Blogkommentare oder Forenlinks können vielleicht 1 – 3 Plätze bringen. Aber letztlich wirken Links nur in der Masse. Bei Links wirkt das additive Prinzip sicherlich: je mehr, desto besser.

Ebenso verhält es sich mit der Textmenge, der Anzahl der Bilder und Videos. Wie man am Beispiel Wikipedia sieht, ist kurzer, präziser Inhalt (noch) nicht ausschlaggebend für Qualität. Bislang gilt (noch) die Devise: je mehr, desto besser. Ich weiß nicht mehr, wer es war, aber irgendjemand hat vor einiger Zeit festgestellt (war es Rand Fishkin?), das Seiten-Ankerlinks, mit denen man zu einzelnen Unterüberschriften auf einer Seite springen kann, ebenfalls ein positives Rankingsignal sind.

Aber was ist nun mit den weiteren Rankingfaktoren, zum Beispiel mit ausgehenden Links? Nach meiner Erfahrung können 2-3 inhaltsrelevante ausgehende Links 1 – 3 Positionen im Google-Ranking bringen – aber eben nicht immer. Genauso verhält es sich mit Videos. Auch Zitate aus Autoritätsseiten wie Wikipedia können sich positiv auswirken, muss aber nicht. Hier gilt jeweils das Prinzip: ein paar sind gut, aber sehr viele bringen nicht mehr.

Twitter-Retweets und Facebook-Likes haben mittlerweile einen deutlichen Einfluss. Wenn ein Artikel in kurzer Zeit hunderte Retweets generiert, dann schießt der Artikel im Ranking nach oben, nicht selten direkt auf Seite 1. Aber der Einfluss dieser Social Media Signal schwindet schnell wieder. Innerhalb weniger Stunden sinkt der Artikel wieder nach unten. Wie weit, kann man schwerlich sagen, denn das hängt immer auch von anderen Signalen ab. Prinzip: je mehr, desto besser, aber die Wirkung verfällt.

Nach meiner Einschätzung immer wichtiger wird die Verweildauer. Google bekommt aus den Toolbar-Daten oder dank Google-Analytics zahlreiche Hinweise, wie lange ein Besucher auf einer Website verweilt. Vielleicht wird sogar schon die Mousebewegung irgendwie getrackt. Natürlich ist das umstritten: was ist mit denjenigen, die keine Google-Toolbar installiert haben? Können Analytics-Werte ernsthaft eine Rolle beim Ranking spielen? Ich denke ja. Google sammelt wie verrückt alle verfügbaren Daten, um genau diese Verweildauer und wenn möglich die User-Interaktion zu analysieren. Julian weist zurecht darauf hin, dass Google natürlich genau schaut, wie man die Suche verfeinert, wenn man nach Klick auf ein Ergebnis schnell wieder in die Suche zurückkehrt. Die Verweildauer wird als Faktor für die Ermittlung von Qualität immer wichtiger. Prinzip: Je länger, desto besser.

Fazit: es gibt sehr viele Rankingsignale, die nach unterschiedlichen Prinzipien wirken. Der größte Teil wird nach meiner Überzeugung aber nur genutzt, um einige „Haupt-Rankingsignale“ zu ermitteln. So könnte ich mir vorstellen, dass die Verweildauer aus hunderten von Einzelsignalen ermittelt wird. Die genannten Beispiele sind natürlich nur exemplarisch, und nicht vollständig.

Das war die Einleitung ;-)

Warum sind Seiten trotz Richtlinien-Verstößen im Ranking?

Nun wissen wir wahrscheinlich alle, dass die Google-Rankings immer wieder für Überraschungen gut sind. Da tauchen Seiten oben auf, die nur aus Werbung bestehen, oder die kaum Backlinks haben, oder mit offensichtlich Footerlinks verkaufen, oder mit verstecktem Text arbeiten, oder keywords-Stuffing betrieben und so weiter und so fort. Der ganze Abschaum elender Seiten, über die man sich als Seo ganz besonders ärgert, weil die wenigen Beispiele eine ganze Branche in Verruf bringen. Warum ist das so? Warum tauchen diese Seiten nach wie vor oben auf?

Ich habe eine Erklärung dafür, die ich im Folgenden als Theorie in den Raum werfen möchte:

Negative Ranking-Signale und die kritische Hürde

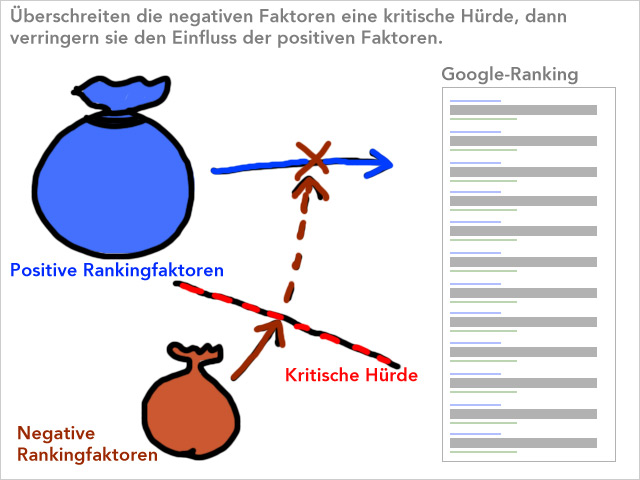

Es gibt positive und negative Ranking-Signale. Die negativen Ranking-Signale haben erst mal keine Auswirkungen. Sie erhalten erst dann Gewicht, wenn sie eine kritische Grenze / Hürde überschreiten. Ein paar Beispiele:

Fast jede Seite kann ein paar „schmutzige“ Backlinks (bad neighbourhood) problemlos verkraften. Logisch, denn sonst könnte man eine Seite problemlos abschießen. Aber ab einer gewissen Anzahl können sich diese Links jedoch negativ auswirken. Dabei untersucht Google natürlich nicht nur die Domains, sondern vor allem die IPs. Je kleiner eine Website, um so weniger schmutzige Links braucht es, um die kritische Hürde zu reißen. Und ab dann wirken nach meiner Theorie alle positiven Faktoren nur noch „gedämpft“, also zum Beispiel nur noch mit 80% ihrer eigentlichen Power. Und wenn die positiven Signale nur noch gedämpft wirken, rutsch so eine Seite natürlich im Ranking nach unten.

Ebenso verhält es sich mit ausgehenden Links. Ein paar „schmutzige“ oder inhaltlich vollkommen irrelevante (Linkverkauf-Verdacht) verkraftet fast jede Seite. Erst wenn eine kritische Grenze überschritten wird, fällt die ganze Site im Ranking nach hinten. In einschlägigen Foren wird dann über eine „Sandbox“ bzw. „Penalty“ debattiert. Das stimmt zwar in gewisser Weise, aber ich denke, dass das eben nicht manuell passiert, sondern algorithmisch.

Oder die „anstößigen“ Begriffe. In der Bildersuche habe ich das schon oft beobachten und auch hier beschrieben. Jede Seite kann sich eine gewisse Anzahl „anstößiger Begriffe“ erlauben, ohne dass etwas passiert. Aber irgendwann ist das Fass dann voll. Und dann schreibt man in irgendeinen Artikel das Wort sexy, und plötzlich verschwinden alle (!) Bilder im safeSearch-Filter. Ich vermute, dass es auch im organischen Ranking eine Art Penalty für anstößigen Text gibt.

Wie viel Werbung ist auf einer Website? Und wie reagieren die Besucher darauf? Verweilen sie, oder klicken sie sehr schnell auf eine Werbung? Ich bin davon überzeugt, dass Google mittlerweile auch analysiert, wie viel Werbebanner sich auf einer Seite befinden und wie die Besucher damit umgehen.

Bis zu einer gewissen Menge hat Google offensichtlich nichts gegen „Duplicate Content„. Denn immer wieder entdeckt man Seiten, die nur aus Zitaten von anderen Seiten bestehen oder zusammengeklaut sind – und trotzdem im Ranking weit vorne auftauchen.

Wie viele Rechtschreibfehler sind auf einer Seite? Wie ist das Sprachniveau? Ich glaube ja schon seit langem, dass korrekte Rechtschreibung ein Qualitätsfaktor sein müsste. Nur beweisen konnte ich das bislang noch nicht :-(

Kurzum: ich glaube, dass es negative Rankingfaktoren gibt, die sich allerdings in aller Regel nicht auswirken. Erst wenn eine Seite zu viele dieser negativen Rankingsignale aufweist, kommen sie zum Tragen – dann aber ganz massiv, und meist betreffen sie die gesamte Site.

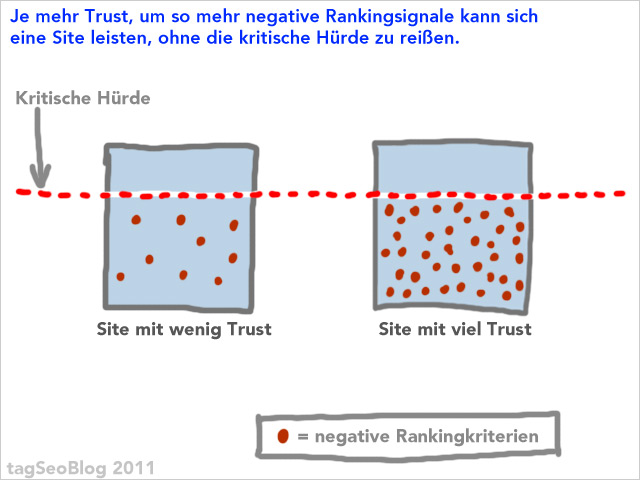

Wie viele „Richtlinienverstöße“ sind OK?

Wie viele negative Signale kann sich eine Seite leisten? Das ist natürlich keine feste Zahl, sondern von der Seitengröße abhängig. Und mit Seitengröße meine ich nicht nur Anzahl der indexierten Seiten, sondern die Größe einer Site bezogen auf uniquen Gesamtcontent (also die Summe aller Artikel und Unterseiten). Man kann diesen Gesamtcontent in einen ewig langen Artikel unterbringen oder auf hunderte Unterseiten verteilen. Die negativen Rankingfaktoren werden stets ins Verhältnis zu diesem Gesamtcontent gesetzt. Je mehr Content man also hat, um so mehr negative Rankingsignale kann man sich erlauben.

Außerdem bin ich davon überzeugt, dass es vom Trust abhängt, wie viele negative Rankingsignale man sich leisten kann. Je höher der ist, um so mehr „Richtlinien-Verstöße“ kann sich eine Seite erlauben. Wer also bislang ein fragwürdiges Geschäftsmodelle konzipiert hat, für den stand eine Frage im Vordergrund: wie kann ich trotzdem möglichst viel Trust aufbauen?

Was passiert beim Panda-Update?

Abschließend noch zur Frage: werden diese negativen Rankingsignale addiert oder wie wirken sie untereinander? Und genau darum schreibe ich diesen Artikel, denn ich glaube, genau das macht das Panda-Update aus. Bislang wurden die negativen Signale nur separat behandelt. Es gab viele Seiten, die die negativen Faktoren bis kurz vor die kritische Grenze ausgereizt hatten, aber eben doch nirgends darüber getreten sind. Nach meiner Theorie hat Google das nun verändert: die negativen Faktoren – oder zumindest eine Teil – werden nach dem Panda-Update zusammen gewertet. Und damit reißen eine Reihe von Websites nun die Hürde, vor der sie bislang erfolgreich umhergehüpft sind.

Fazit

Langer Rede, kurzer Sinn: ich denke, man sollte als SEO nicht nur darauf achten, positive Ranking-Signale aufzubauen, sondern auch, negative zu minimieren. (Puh, so viel Text für so ein kurzes Fazit :-) )

Was meint ihr? Plausibel? Oder nur wilde Spekuliererei?

Weitere interesante Artikel zum Thema

- Seo-Trainees: „Content über Content„

- Sistrix: „Panda-Update: erste Überlegungen„

- Seo-United: „Panda Update – Gewinner und Verlierer in UK„

- mySeoSolution: „Googles Farmer aka. Panda Update„

Update: Video von der Affiliate Tactixx

Danke an Han Seo für den Hinweis auf das folgende Video, das gut zum Thema passt:

Affiliate Tactixx 2011 – Podiumsdiskussion „Search Roundtable“ from explido WebMarketing on Vimeo.

45 Gedanken zu „Negative Rankingfaktoren, Prinzip der „kritischen Hürde““

Durchaus ein sinniger Ansatz. Allerdings kommt mir dabei, auch wenn Du es verlinkt hast, die Komponente des Contents etwas zu kurz.

Des Weiteren denke ich dass man mit positiven „Signalen“ wie zum Beispiel Tweets oder Likes einiges an Negativem wett machen kann. Sich das quasi aufwiegt, sofern Google den Inhalt als besonders wertvoll einschätzt.

Aber letztlich bleibt uns, wie eigentlich immer, nur das probieren und schlussfolgern übrig :)

Boah, Leute, sorry. Ich glaube, dass hätte man auch kürzer schreiben können.

Wär’s kürzer gewesen, hätte ich nicht so lange dran gelesen ;-)

Ich kann mir nicht vorstellen, dass Google einzelne Faktoren (negative) bisher unabhängig voneinander gewertet hat. Eher, dass jetzt bestimmte Faktoren höher negativ gewertet werden, wenn Google alles miteinander verwurschtelt.

Hallo Martin, schöner Artikel, der bestimmt nun eine Spekulationswelle auslösen wird.

Ich denke aber das man den oder die Algos die das Google Ranking ausmachen bzw. berechnen nicht so einfach zusammen zu fassen sind.

Kleiner Fehler den ich am Rande gefunden habe: „Nach meiner Beobachtung hat ein Link hat deutlich weniger“. Den Fehler behalte ich aber :-)

@Ahmet: ja, das mit der Spekulationswelle liegt mir auch irgendwie quer. Aber irgendwie muss man ja mal anfangen, etwas weiter zu denken, als immer nur 200 und mehr Rankingfaktoren aufzulisten.

Den Fehler habe ich übrigens schon geklaut :-) (und getilgt). Danke

Zum Thema Rechtschreibung:

Nach meinen Beobachtungen spielt diese noch keine Rolle, ich halte es aber ähnlich wie du für sehr wahrscheinlich und folgerichtig, diese in die Bewertung von Content maßgeblich einfließen zu lassen.

Qualitativ hochwertiger Content zeichnet sich insbesondere auch durch nahezu fehlerfreie Rechtschreibung, Grammatik und Interpunktion aus.

Ich halte es allerdings für sehr komplex Rechtschreibfehlerquoten automatisch zu ermitteln, selbst gute Desktopsoftware hat damit auch heute noch ihre Probleme, v. A. auch bei der deutschen Sprache.

Hinzu kommen Probleme mit Neologismen etc., die gerade im Web häufig verwendet werden.

Lösungen zur Ermittlung von Fehlerquoten wären also maximal kleinste gemeinsame Nenner wie Whitelists mit eindeutig ermittelbaren Falschschreibweisen.

Dennoch wird es einfacher sein Textqualtität daran zu bemessen als am eigentlichen Inhalt und dessen (inhaltliche) Fehlerfreiheit, da praktisch unmöglich algorithmisch verifizierbar.

Wenn, dann dürften wir soetwas wohl zuerst im englischsprachigen Bereich beobachten können, Englisch ist weniger komplex in der Rechtschreibung und vielfach logischer – demnach also auch algorithmisch einfacher auszuwerten – als andere Sprachen wie z. B. das Deutsche.

Finde den Artikel echt Interesant Danke dafür. Ich habe gesehen das mancher trotz unmegen fauler Inlinks sehr weit Oben stehen kann, bestätigt also die Theorie…

@Enrico (ganz am Anfang): Vielleicht habe ich es nicht deutlich machen können: der ganze Artikel dreht sich um die Frage, was guter Content ist. Der Googlebot kann ja bei der Bewertung nicht hergehen und sagen: „Hm, ja, die Seite gefällt mir, genau das habe ich gesucht!“ Stattdessen muss Google algorithmisch ermitteln, was gut und was weniger gut und was schlecht ist. Ich denke, welche Art von Formulierung gut und welche schlecht ist (ich vermute, das meinst Du mit „Content“), ist nicht nur ein winziges Teilchen, sondern vor allem nicht algorithmisch zu erfassen. Google braucht dafür Daten, die messbar sind.

Eine Seite, die Inhalte für Jugendliche bietet, zum Beispiel Grafitti-Tags oder so, ist mit einer Jugendsprache sicherlich erfolgreicher als mit „Professoren-Duktus“. Und für die Seite mit Kochrezepten gilt wieder etwas anderes. Die reine Auswertung von Sprachniveau im akademischen Sinne wird die Qualität der Suchergebnisse nicht verbessern können, weil viele keys eben bestimmte Zielgruppen ansprechen.

Hi Martin,

Super Artikel, hab nur 3 Versuche gebruacht um ihn durchzulesen. Man wird ja dauernd abgelenkt ;-) Also ich glaube ich hab deinen Artikel so verstanden: Je mehr gutes man tut, desto mehr schlechtes darf man sich erlauben?

LG, Marcel

Hallo Martin,

sehr schöner (langer) Artikel :) und auch kurzweilig zu lesen. Unterm Strich ziehe ich folgendes heraus: „Je mehr positive Faktoren wie z.B. Trust, Qualität der Inhalte, Verweildauer der Besucher auf der Seite, Erwähnungen im Social-/Open-Graph für eine Domain vorliegen, desto mehr negative Rankingfaktoren „verkraftet“ diese Domain bis diese abgestraft wird. Anders gesagt, je größer die positive Reputation einer Domain ist desto mehr wird ihr „verziehen“ ;).“

Das macht auch Sinn. Ich kann an dieser Stelle das Video des Search Roundtable Panel “Entwicklungen im Bereich Suchmaschinen” auf der letzten Affiliate TactixX empfehlen. Hierbei werden gerade auch in Bezug auf Qualität und der Verweildauer interessante Aspekte besprochen.

Viele Grüße aus Köln,

Jens

Sehe ich generell genauso. Gerade die Sache mit dem „Ich hab Trust, ich kann mehr Mist bauen“. Ich denke ein schönes Beispiel dafür sind die „großen“ Newsaggregatoren, die viel Power haben. Da hat man häufiger mal fast identische Artikel auf verschiedenen Portalen, die aber dennoch sehr gut ranken. Wäre ein Indiz für eine „DC Schwelle“.

Grüße

Pascal

@Han Seo: Danke für den Hinweis auf das Video. Habe ich oben ergänzt, mit Link zu Deinem Artikel.

@tagSeoBlog

Danke für Deine Antwort, auch wenn ich etwas anderes gemeint habe ;)

Das man anhand des Sprachstils „guten“ von „schlechten“ Content schwer ermitteln kann ist mir klar. Allerdings gehen die Vermutungen ja dahin dass „guter“ Content an Hand verschiedener Kriterien wie Bildern, Videos, Überschriften, Zitaten, Linktexten ausgehender Links und so weiter erkannt werden kann. Das macht für mich in sofern Sinn dass ein reiner SEO-Text oft nur aus 200 bis 400 Wörtern besteht, kein Bild, selten Teilüberschriften und Videos und eben sehr SEO-Freundliche Linktexte (nämlich Keywords). Kommt nun noch hinzu dass die Website Interaktionsmöglichkeiten in Form von Kommentaren und Likes bietet ist auch oft zu beobachten dass SEO-Texte wenige bis keine Reaktionen erhalten, der Informationsgehalt ist ja oft auch eher mau.

Das sind jetzt natürlich nur Vermutungen, denn ich tue mich sehr schwer damit Content zu bewerten (eben weil die genauen Parameter fehlen).

Aber gut, das hat jetzt auch nur tendenziell etwas mit Deinem Artikel zu tun ;)

sehr schöner Artikel! Selbst wenn deine Theorie nicht hundertprozentig zutrifft, finde ich die Erklärung wichtig, auf welche unterschiedlichen Arten Faktoren wirken.

Google vergibt eben nicht nur eine Anzahl von Plus- und Minus-Punkten, die einfach addiert werden. Dann würden die einzelnen Faktoren tatsächlich rein linear wirken. Das trifft vielleicht noch auf die Link-/bzw. Domain-popularität zu. Für die meisten Faktoren scheint es aber eine kritische Schwelle zu geben, die sie erst erreichen müssen, bevor sie eine Seite wirklich pushen oder abstürzen lassen.

Hi Martin,

Also alleine beim Title fallen mir schon 4 verschiedene Kriterien ein:

Position des Keywords

Vorhandensein (hattest du ja)

Länge des Titles

Klickrate des Titles

Eines („Vorhandensein des Keywords“) reicht also bei Weitem nicht aus. Auch bei der Verweildauer gilt nicht „je länger desto besser“. Wenn jemand direkt das findet, was er gesucht hat, dann ist er nach 3 Sekunden vielleicht weg, aber seine Suchanfrage war trotzdem eine „satisfied search“.

Bei der Theorie mit der „kritischen Hürde“ gebe ich dir völlig recht. Es ist aber auch schon vor Panda so gewesen, dass große Marken sich viel mehr in Sachen SEO erlauben konnten als kleine Webseiten. Aber gut, dass du es mal in aller Deutlichkeit geschrieben hast!

Schöner Artikel und interessante Theorie! ;)

Um deine Idee mal weiterzuführen bzw. zu diskutieren: Vielleicht geht das Panda genau in die Richtung, dass generell die Hemmschwelle wie hoch die Anzahl „negativer Signale“ ist zum einen gesenkt wird (seh ich auch so) und zum anderen gegegnüber anderer positiver Signale gewichtet wird. Das sich eben genau die positiven Signale (Anzahl, Art, etc.) in Ihrer Gewichtung mit dem Panda Update ändern? Da bleibt nur weiterhin eine Frage: Welche positiven Signale sind nach dem Pana Update wie hoch neu-gewichtet? Ich werf schonmal eins im Raum (eigentlich hast du zuerst geworfen ;) – hochwertiger Inhalt wird als positives Signal steigen und wer das hat, kann in Zukunft auch ein paar mehr Böcke bei den negativen schießen (Aufgreifen deiner Theorie Ende).

@Enrico: bei Deinen Formulierungen stört mich, dass Du minderwertigen Content offenbar „Seo-Texte“ nennst ;-) Ich würde das Gegenteil behaupten. Ansonsten gebe ich Dir Recht :-)

@Nikolas: interessante Überlegung, dass es auch bei den positiven Ranking-Faktoren eine kritische Hürde gibt. Das könnte so manche „Verzögerung“ bei Social-Media-Signalen erklären.

@Julian: Hast natürlich Recht: allein beim Titel sind es schon vier, wobei das entscheidende Kriterium sicherlich das Vorhandensein ist. Länge und Position sind eher Mini-Stellschrauben, die nach meinen Beobachtungen seit einiger Zeit kaum noch Relevanz haben, oder?

Die Sache mit der Verweildauer bzw. Bounce-Rate (im Sistrix-Artikel ausführlich diskutiert) ist sicherlich schwieriger und vermutlich auch abhängig von der Artikellänge.

@Tanja: ich glaube, das ist längst ein Faktor. Zumindest sind Seiten mit lausiger Rechtschreibung bei dem, was ich suche, in den Top10 inzwischen sehr selten. Vielleicht will da mal jemand einen Test aufsetzen ;-)

Wirklich schöner Artikel. Umfangreicher Inhalt mit vielen Bildern und die Nähe zu Trusted Sites.. Wikipedia und Spiegel-Links sind mein täglich Brot ;-) Gibt es eigentlich mal eine vermutete Trusted Sites Liste?

Ich glaube aber, dass Inhalte Kategorisiert werden. Wetter-Seiten werden eine andere Verweildauer als Kino-Seiten haben.

Wenn man im harten Wettbewerb ist, kann man negative Signale nicht immer verhindern oder zurückbauen (lasen). Man muss einfach schneller postive Signale aufbauen..

Der Artikel hat mir wirklich sehr gut gefallen, dennoch:

Die Vorstellung von der Funktionsweise des Google-Algorithmus scheint mir oft etwas „naiv“ zu sein. Grund dafür könnte die Frustration über nicht selten allzu offensichtlich sub-optimale Ergebnisse sein, die aber tendenziell eher der Komplexität der unglaublich herausfordernden Aufgabe geschuldet sein dürfte, so viele unterschiedliche Arten von Webseiten und Suchanfragen bzw. intendierten Suchbedürfnissen in einem so dynamischem Umfeld wie dem Internet unter einen Hut zu bringen, als der Verwendung von zu wenigen Faktoren und/oder „falschen“ Gewichten bzw. Verknüpfungen im Algorithmus.

Davon auszugehen, dass dieser oder jenes Signal (etwa nach dem Panda-Update) praktisch im Alleingang den Ausschlag für eine signifikante Rankingveränderung gegeben habe oder dass negative Rankingfaktoren bisher nicht schon in Kombination betrachtet worden wären, gehört m. E. dazu. Auch beim Thema Seiten-Titel halte ich noch eher 40 (http://www.seoptimise.com/blog/2010/08/40-title-tag-seo-for-google-ranking-factors-optimization-techniques-resources.html) als nur 4 Faktoren für – mehr oder weniger – relevant.

Das Internet entwickelt sich eben extrem schnell, weswegen der Algorithmus permanent und insgesamt mehrere hundert Mal pro Jahr optimiert wird. Manchmal muss Google aber auch auf „öffentlichen Druck“ reagieren (Beispiele: Links im Rahmen von schlechten Bewertungen werden jetzt nicht mehr positiv gewertet oder „thin & SEO’d content suck increasingly“) – und dann rappelt’s für einige „Spezies“ eben etwas mehr als für die überwiegende Mehrheit der Webseiten.

Markus: Danke für die kritischen Worte. Ich glaube, es gibt inzwischen so viele Rankingfaktoren, dass die allermeisten kaum relevanten Einfluss haben können. Der gesunde Menschenverstand sagt mir, dass es es im Google-Algo Prinzipien und Methoden geben muss, die wichtiger sind als Mini-Faktoren wie Kommata im Seitentitel. Darum geht es hier.

Anders gesagt: ich glaube, dass sich die Google-Algo-Analyse weg von der Untersuchung von Einzelkriterien hin zur Frage bewegt: was hängt wie warum zusammen?

Danke für den Link, aber 40 Faktoren alleine für den Titel auszuwerten ist doch irgendwie Quatsch, oder? … selbst wenn Google sie alle in Betracht ziehen sollte, was ich bezweifel.

Ich würde sagen macht einfach euren Job als Webmaster und macht gute Seiten. Dieses Quick und Dirty ich tricks den Bot mal aus kostet genau soviel energie wie ein echtes Projekt.

Interessant finde ich den Aspekt der negativen Wirkung von ausgehenden Links. Ich hatte dazu mal ein Experiment gestartet, allerdings zum Thema „Wie komme ich in den SafeSearch-Filter“ (http://bit.ly/9LBXqd). Schon zwei Links auf Porno-Seiten in einer Kopie eines Wikipedia-Artikels hatten damals (2010) dafür gesorgt, dass die Seite in den SafeSearch-Filter gerutscht ist. Ich will von diesem Ergebnis nicht auf die eigentlichen SERPs schließen, zumindest aber vermute ich, dass Google ein Verhältnis von „guten“ ausgehenden Links zu „schlechten“ ausgehenden Links berechnet. Könnte man mal in ein Experiment pressen…

@Axel: stimmt. Aber man kann das eben auch komplizierter begründen ;-)

@Thorsten: mach mal ;-)

Hallo,

nachdem ich mir das Video angesehen habe, überlege ich mir einen Bart wachsen zu lassen ;-)

Grüße

Gretus

@Gretus: gibs zu: Du bist gerade erst mit dem Artikel fertig geworden und Dir ist schon ein Bart gewachsen :D

@tagSeoBlog

Ich meine die klassischen Texte die auf Blogs, Artikelverzeichnissen und Presellpages veröffentlicht werden, meist gespint sind und nur selten einen Wert für den Leser darstellen. Das ist für mich ein „SEO-Text“. Also nicht falsch verstehen, ich will hier niemanden diskreditieren ;)

Interessanter Ansatz! … und verdammt langer Artikel. In Einem stimme ich Dir voll und ganz zu – qualitativ hochwertiger Content ist das wichtigste Überhaupt.

Und im Prinzip sollte man einfach nur Gutes tun, dann muß man damit auch nichts Schlechtes ausbügeln! ;)

Hi,

toller ansatz!

du sagst also:

„Fast jede Seite kann ein paar “schmutzige” Backlinks (bad neighbourhood) problemlos verkraften.“

Das glaube ich auch, aber ich frage mich, in wiefern Google diese Links bewertet!?

Wenn diese Links aus der Bad Neighbourhood aber z.B. von einer starken Bad Neighbourhood-Quelle kommen (viele Links, hoher SI, PR oder sonstwas). Glaubst du, dass sich der Juice dann trotzdem „positiv“ auf die verlinkte Seite auswirkt oder nicht?

Also anders formuliert: glaubst du, dass starke Links aus der Bad Neighboorhood trotzdem „gut“ sein können, da sie ggf. leichter zu bekommen sind?

Sehr guter und verständlicher Artikel. Ich bin ebenfalls der Meinung das Google die Daten aus Analytics nutzt um das Nutzerverhalten für die Suchergebnisse zu ermitteln. Finde ich persönlich vielleicht aber nicht so schlecht, denn Seiten die man aufgrund von penetranter Pop Ups sofort wieder verlässt werden dann zwangsläufig abgestraft.

Mit dem Seitentitel gebe ich dir absolut recht. Meiner Meinung nach ist das ähnlich wie bei einem Buch: Seitentitel ist wie der Buchtitel, Meta Beschreibung wie die Inhaltsbeschreibung auf der Rückseite des Buches. Erstellt man beides gewissenhaft und gründlich ist das schon die „halbe Miete“.

Hello Martin,

Although your Seo blog is in German language,I have just read by using Google Translate Tool.

You mention true Rank factors for Search Engine Optimization (Seo).Especially for Google Search Engine,you say extremly useful explanations here.

I am sure that this information here will be useful for blog readers.

Sehr guter Artikel, im Grunde alles nachvollziehbar, ich würde aber dem Webmastertool wesentlich mehr Beachtung schenken – alle Themen die dort aufscheinen sind SEO relevant.

Das ist ein echt professioneller und gut aufbereiteter Beitrag. Als SEOistin habe ich festgestellt, dass die URL sehr viel Wirkung hat. Wenn das oder die Keywords in der URL zbs. http://www.xyz-keyword.de vorkommen, bringt das für’s Ranking enorm viel. Tags und Description sind noch immer wichtig und contentrelevante Backlinks ebenso. Am besten ist es, an schaut es den Profis einfach mit einem Backlink-Tool ab.

[Edit vom Admin: sorry, wer 7 Kommentare unter anderen Namen mit stets verschiedenen URLs abgibt, aber immer die gleiche IP hat, macht sich verdächtig. Ich habe daher alle URLs gelöscht. ]

Hallo Martin. Sorry, aber wir sind eine Gruppe von SEO Interessierten und alle haben halt eine andere URL. Dann schreiben sie halt von Zuhause aus.

Gruss Petra

Auch bald ein Jahr später hilft dieser Artikel noch sehr dabei, die rote Blog-Linie zu finden. Vielen Dank dafür!

Es ist übrigens lustig, dass Du schreibst „Ich glaube ja schon seit langem, dass korrekte Rechtschreibung ein Qualitätsfaktor sein müsste.“ und aber in diesem Beitrag (und wahrscheinlich auch in anderen) Fehler enthalten sind. Teils nur Tippfehler und für mich als Leser ja auch überlesbar. Nur müsstest du dann deine Seite nicht dahingehend optimieren, wenn Du sagst, dass es ein Ranking-Faktor wird, sobald eine kritische Masse überschritten ist?

Na interessant dieser Artikel. Also zählt mal wieder alles oder nichts im Jahr 2013?!:-) Am besten, man macht von allem etwas richtig bei der Suchmaschinenoptimnierung für Google. Dann klappts auch mit dem Ranking. Sehe ich das so richtig?

Kommentare sind geschlossen.