Google March Core Update 2019 – Was nun? (Seo-Campixx 2019)

Wie versprochen, fasse ich im folgenden meine bisherigen Erkenntnisse zum March Core Update 2019 zusammen. Da ich viel verloren habe, habe ich auch viel drüber nachgedacht :-) Es handelt sich in Auszügen um meine Präsentation bei der Seo-Campixx 2019. Da ich dort jedoch noch zahlreiche sehr interessante Gespräche zu dem Thema führen konnte, ergänze ich diese Überlegungen sinnvollerweise zu einem Gesamtpaket. Es geht dabei um drei Fragen: Was ist betroffen? Was ist die Ursache? Was kann man tun? Am Ende erwähne ich noch eine sehr spannende „Meta-Theorie“ – wahrscheinlich falsch, aber vom Ansatz her verblüffend :-)

Wann war das March Core Update 2019?

Das March 2019 Core-Update begann am vergangenen Mittwoch, den 13.3. und dauerte ungefähr zwei Tage, ehe alles ausgerollt war. Seit Samstag, also einen Tag nach der Seo-Campixx, scheinen die Rankings wieder stabil zu sein. Fast wie abgesprochen :-)

Allerdings habe ich inzwischen schon wieder einige kleine Gegenbewegungen beobachtet, zwar nur im kleinen Rahmen, aber immerhin. Websites von mir, die von Position 1 auf Pos. 10 abgerutscht waren, sind inzwischen wieder auf Pos. 9 oder 8 zu finden.

Was sind (theoretisch) mögliche Ursachen?

Welche Ursachen kommen prinzipiell in Frage und was wurde spontan nach dem Update so kommuniziert? Der Einfachheit halber habe ich es in drei Bereiche eingeteilt:

- Gewinner-Theorien (Update-Gewinner haben etwas gut und richtig gemacht, Verlierer sind Kollateralschaden)

- Brand-Status: große Brands gewinnen durch Vertrauensbonus

- User-Signals: Seiten mit geringerer Bounce-Rate und längerer Verweildauer werden bevorzugt

- Links ziehen wieder!

- Verlierer-Theorien (Update-Verlierer haben etwas falsch gemacht, Gewinner sind Kollateralschaden)

- Thin-Content

- Duplicate-Content

- Onpage-Schludrigkeiten

- Schlechte mobile User-Experience

- Content-Netzwerke werden nun als Link-Netzwerke abgestraft.

- Sowohl-Als-Auch-Theorien (es sind neue Kriterien hinzugekommen oder modifiziert worde, so das es Gewinner und Verlierer gibt)

- Autorität / Expertenstatus: wie zuverlässig ist der Autor bzw. Betreiber der Website?

- User-Intention: welche Art von Ergebnis erwarten die Suchenden?

Was ist betroffen?

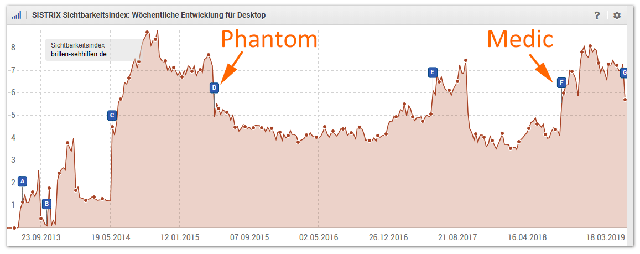

Für meine Campixx-Präsentation habe ich bei meinen (Verlierer-)Domains untersucht, welche Keywords eigentlich betroffen sind. Dabei zeigte sich, dass überwiegend der Shorthead betroffen ist, vorrangig Single-Keywords. Diese Beobachtung wurde von vielen anderen Verlierern (und einigen Gewinnern) bestätigt. Das scheint aus meiner Sicht inzwischen relativ gesichert zu sein.

Veränderungen im Shorthead wirken sich stets recht dramatisch aus: da das Suchvolumen hoch ist, schlagen sich Positionsveränderungen sofort in den Traffic-Statistiken nieder. Ebenso zeigen sich starke Auswirkungen beim Sichtbarkeitsindex, den die großen Toolanbieter auf Basis des prognostizierten Traffics (und weiteren Werten) berechnen.

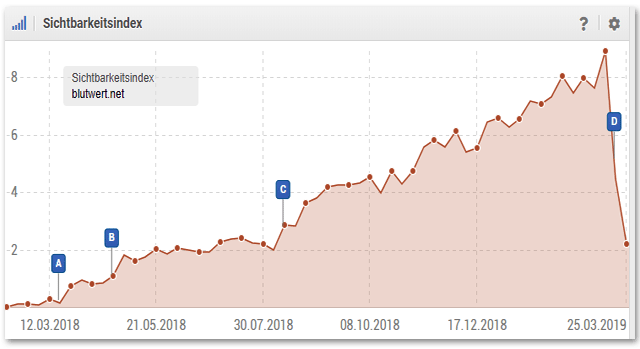

Wichtig ist (in vielerlei Hinsicht), dass meine Seiten nach wie vor viele gute Rankings haben, aber eben nur noch im Longtail (mehr als ein Suchbegriff, 2-4 Worte, teilweise sogar Sätze). Als Beispiel zeige ich einen Screen aus Sistrix, der die Rankingverteilung meiner Website Blutwert.net vor und nach dem Update zeigt:

Man erkennt schön, dass es nach wie vor sehr viele Platzierungen in den Top-10 gibt (Page 1). Was man leider nicht sieht, ist der Abfall bei vielen Keywords von Pos. 1 oder 2 auf Position 8 oder 9.

Dennoch gibt es gerade im Longtail noch viele Top-Rankings. Diese – und alle anderen meiner Websites – haben nicht alle Pos. 1-Rankings eingebüßt – sondern eben nur die im Shorthead .

Phantom II (?)

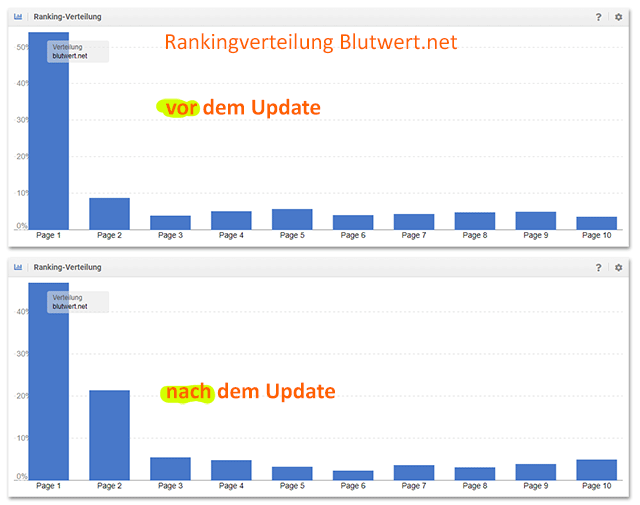

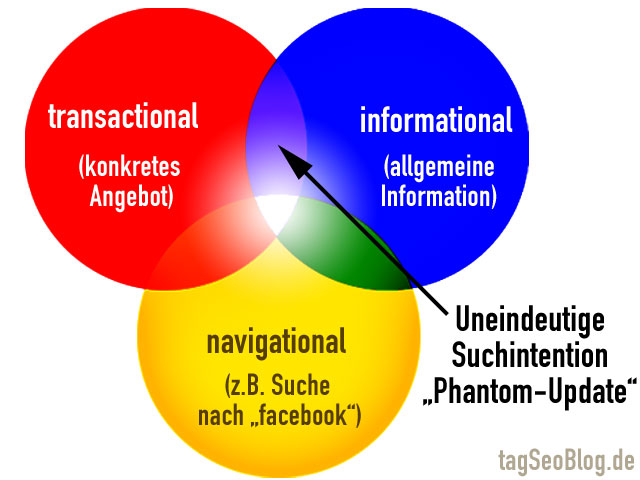

Hohes Suchvolumen? Verluste im Shorthead? Überall da, wo die User-Intention nicht eindeutig ist? … Das kennt man doch! Genau: das Phantom-Update!

Schon im Mai 2015 habe ich arg Feder gelassen, und letztendlich halfen alle Maßnahmen nichts. Damals hat Google die Suchergebnisse grundlegend umgestellt. Das betraf alle Shorthead-Suchanfragen, bei denen die Suchintention nicht aus der Anfrage deutlich wurde (Beispiel damals: „Gleitsichtbrille“). Seinerzeit habe ich mein langjähriges Pos. 1 Ranking verloren – und gewonnen hatten die Brillen-Anbieter. Zugespitzt würde ich das Phantom-I-Update daher als „Anbieter schlägt Ratgeber“ zusammenfassen. Hier die Grafik, die ich seinerzeit erstellt hatte:

Das scheint sich auch jetzt abgespielt zu haben – oder zumindest mitzuwirken:

- Nur „uneindeutige Suchanfragen“ sind betroffen.

- Reine Ratgeberseiten haben für diese Keywords an Positionen verloren.

- Anbieter gewinnen nun die vorderen Plätze.

These 2: Duplicate Content kein positiver Rankingfaktor mehr (?)

Eine alternative oder ergänzende These betrifft den Seiteninhalt. Dabei geht es um „Duplicate Content„. Allerdings bin ich schon lange nicht mehr das Ansicht, DC sei eine 1zu1-Kopie eines Textes. Stattdessen denke ich inzwischen nur noch im Sinne von „inhaltlicher Gehalt„, man könnte auch sagen: Fakten (wobei ein Fakt viel weniger ist als ein inhaltlicher Gehalt).

Bei mir ergeben sich solche DC-Seiten quasi aus dem Workflow heraus. Wenn ich einen Unterbereich eines Themas erarbeite, beginne ich meist damit, das inhaltliche Fundament breit aufzustellen, so wie bei einer Pyramide. Ich arbeite mich also vom Konkreten (fokussierte Unterseite) hin zum Allgemeinen (Übersichtsseite, Kategorieseite).

Interessanterweise sind diese Übersichtsseiten nun genau die, die im Shorthead nun Ranking-Positionen eingebüßt haben. Die Basis ist stabil, die Spitze ist abgebrochen. Im Grunde zurecht: denn ich habe dort im Wesentlichen Zusammenfassungen der Unterseiten als eine Art „Hub-Page“ zusammengeführt.

Genau das scheint mir auch bei diesem Update eine Rolle zu spielen: Hub-Pages können als Verteilerseiten eine uneindeutige Suchanfrage nicht wirklich gut beantworten. Man muss sich entscheiden und dann weiterklicken. Diese Entscheidung kann Google dann allerdings nicht mehr „messen“ und analysieren. Daher wurden solche Seiten herabgestuft. Gewonnen haben Seiten, anhand derer Google viel eher algorithmisch verstehen kann, was die Suchintention ist.

Dass eine Hub-Page nur Duplicate-Content sei, ist natürlich eine steile These :-) Wo endet DC – und wo beginnt Uniquenes? Hat Google „Sprachstil“ und „inhaltlichen Gehalt“ nun voneinander getrennt? Wie misst man „inhaltlichen Gehalt“, wenn man den Sprachstil davon abzieht? … Das Thema „Definition von DC“ ist aus meiner Sicht sehr spannend und ich werde das in einem Folgeartikel noch einmal thematisieren.

Ursachenforschung: was kann man ausschließen?

Ich würde folgende Theorien als Ursache dieses Updates ausschließen:

- Links: Alles was mit Links oder der Linkbewertung zu tun hat, scheint mir nach allen untersuchten Beispielen eher abwägig zu sein. Dass

die Linkprofile in Einzelfällen möglicherweise Übereinstimmungen zwischen Gewinnern als auch Verlierern zeigen, ist logisch. Aber das heißt ja nicht, dass es hier eine Ursache wäre. - Link-Netzwerk: auch wenn ich mehrere Domains betreibe und die an sinnvoll geeigneten Stellen untereinander cross-verlinke, so heißt das nicht, dass Google das als Link-Netzwerk ansieht. Im Falle einer Abstrafung wäre sicherlich die gesamte Domain betroffen, nicht nur die Shorthead-Keywords.

- Brand: Da es auch viele Gewinner gibt, die einen hohen Brand-Staus haben, kann man diesen Punkt wohl auch ausschließen. Siehe dazu die Gewinner-Verlierer-Listen bei Sistrix oder Searchmetrics)

- Expertise / Autorität: Auch wenn das zunächst nahe lag, würde ich es inzwischen ebenfalls ausschließen. Es wäre unlogisch, dass meine Seiten im Longtail so viele gute Platzierungen behalten haben. Wenn meine Inhalte von Google als „nicht-verrauenswürdig“ eingestuft worden wären, müsste das in der Folge alle Unterseiten betreffen. Zumal die lontailigen (eindeutigen) Suchanfragen im Sinne des Vertrauens oft viel heikler sind.

- Thin-Content: die Verschiebungen betreffen auch und vor allem die vorderen Plätze von Keywords mit hohem Suchvolumen. Es ist sehr unwahrscheinlich, dass hier noch Thin-Content zu finden war und wäre.

- Onpage-Schludrigkeiten: auch wenn es bei mir auf der Website eine Reihe kleinerer Onpage-Fehler gibt (z.B. 404-Links, 301-Weiterleitungen) – eine Abstrafung dafür scheint sehr unwahrscheinlich. Natürlich sollte man das stets im Blick haben – aber solange das nicht überhand nimmt, wird es kaum zu einer größeren Abstrafung führen, die mehr als konkrete Einzelseiten betrifft.

Ursachen des Core-3-Updates

Drei wichtige Punkt, die ebenfalls als Ursache in Frage kommen, wurden bei der Campixx intensiv diskutiert, daher erwähne ich sie hier:

- User-Experience: stimmen die Rahmenbedingungen auf der Website? Fühlt sich ein Benutzer wohl? Weiß er, wo er ist und worum es geht? Sieht die Umgebung vertrauenswürdig aus? Hat er die Möglichkeit, sich sinnvoll weiter zu navigieren? Diese Fragen habe ich in der Vergangenheit vernachlässigt, einfach weil zu sehr mit neuen Inhalten beschäftigt war. Die User-Experience ist sicherlich in sehr wichtiger Hebel für langfristigen Erfolg. Möglicherweise bewertet Google die UX für Top-Ergebnisse für (uneindeutige) Shorthead-Anfragen anders als im Longtail.

- UX auf Mobilgeräten: Der zuvor genannte Punkt wird besonders wichtig, wenn man die UX auf Mobilgeräten anschaut. Ich arbeite nach wie vor am PC mit großem Screen. Vieles, was da optisch gut funktioniert, ist in der mobilen Ansicht Mist, zum Beispiel Tabellen, große Bilder etc. Auch hier muss ich lernen, mobile First ernst zu nehmen und letztlich eine Website nur noch mobil zu prüfen. Auf dem Desktop ist soweiso alles gut …

- CTR / Klickrate in den Serps (?): diese These brachte Marcus Tandler ins Spiel, und ich bin noch unschlüssig. Führt eine schlechtere Klickrate in den Suchergebnissen zu einer Herabstufung? Und wenn das so ist, warum dann so plötzlich und umfassend in einem Core-Update? So oder so ist es aber vermutlich immer sinnvoll, die Snippets in den Serps zu optimieren …

Und dann sind da noch die zwei Aspekte, die ich oben schon genannt hatte:

- Anbieter vor Ratgeber, User-Intention im Shorthead: bei uneindeutigen Suchanfragen werden jetzt eher Anbieter-Websites bevorzugt (so wie bei Phantom I). Reine Ratgeber kommen erst weiter unten, für die, die für Informieren.

- Hub-Pages vs. User-Intention: Übersichts- und Verteilerseiten, die nur auf umfangreiche Unterseiten weiterleiten, sind nicht geeignet, um eine (uneindeutige) Suchintention zu befriedigen.

Was folgt daraus? Welche (SEO-)Maßnahmen?

Für mich (!) ergeben sich aus dem Gesagten mehrere konkrete Punkte, die ich nun umsetze bzw. umsetzen werden.

- Interne Suche: auf vielen meiner Seiten gibt es noch keine gute intere Suchfunktion. Und wenn sie da ist, dann ist sie meist nur in der Desktop-Version u sehen, weil sie mobil irgendwo nach unten rutscht. Das werde ich nach und nach auf allen meinen Domains verbessern.

- Bread-Crumbs / bessere Orientierung: eher aus Faulheit hatten meine Websites bisher keine Bread-Crumb, die dem Besucher sofort anzeigt, wo man sich innerhalb der Seite befindet. Auch das werde ich nun überall einführen.

- Autoren-Box: bisher gabe es auf meinen Seiten lediglich einen Link zu meiner Künstler-Homepage sowie eine kurzinfor im Impressum. In Zukunft werde ich auf jeder Domain eine umfangreiche Autorenseite anlegen. Zudem wird es unter jedem Artikel eine Autoren-Box geben, in der ich kurz vorstelle, warum ich geeignet bin, auch medizinische Themen zu bearbeiten. (Btw: dass ich seit Jahren als „Künstler“ auftrete, ist norstalgischer Blödsinn. Ich bin Experte im Vermitteln von komplizierten Inhalten für Menschen ohne Vorwissen – auch und besonders mit Hilfe von Bildern und Grafiken.)

- Übersichtsseiten (Kategorieseiten): Verbesserung der Inhalte meiner „internen Hubs“. Vor allem anfangs eine Kurz-Zusammenfassung sowie unique Inhalte, die nur auf der Übersichtsseite zu finden sind.

- Title-Optimierung: viele Seitentitel bei mir sind „konzept-basiert“. Sie folgen der Logik der Seitenstruktur. Allerdings sind Keywords und die dahinter liegende Intention natürlcih ganz verschieden. Ich werde daher die Title meiner Seiten anpassen – insbesondere natürlich bei den Seiten, wo ich Positionen verloren habe.

- Mehr Seiten-Navigation: auf vielen Seiten habe ich noch keine separate Seiten-Navigation. Das kann insbesondere auf mobilgeräten viel Scroll-Arbeit abnehmen. Zudem hat man so auch die Möglichkeit, Mini-Sitelinks in den Suchergebnissen zu bekommen.

- Mehr „Angebote“: was kann ich meinen Besuchern bieten – jenseits eines Online-Shops? Auch eine Ratgeberseite kann ihren Besuchern Dinge anbieten: Checkslists, Videos, Newsletter (werde ich aber auch in Zukunft nicht machen :-)), Downloads, etc.

Bonus: die Meta-These

Eine sehr coole Überlegung kam mir beim Essen mit Tbis Schwarz und anderen: was, wenn es ga nicht einzelne konkrete Ursachen sind, sondern quasi alles betrifft. Hintergrund ist die Überlegung, dass Google ja offensichtlich auf verschiedenen Ebenen zeitliche Verzögerungen in den Algorithmus eingebaut hat. Sei es, um Spam vorzubeugen oder um kurzfristige Schwankungen zu verhindern. Viele Seos wissen, dass oft Wochen vergehen, ehe Veränderungen wirklich in den Suchergebnissen sichtbar werden.

Was wäre denn nun, wenn Google alle (!) verzögerten Veränderungen plötzlich auf einen Schlag raushaut? Also von heute auf morgen quasi seinen gesamten Bestand auf einen „Neustart“ setzt. Von hier aus können nun wieder User-Signale gesammelt werden und zeitliche Verzögerungen wirksam werden …

Klingt interessant, ist aber wohl nie zu verifizieren :-)

Wie sieht es bei Euch aus? Ist das im Rahmen Eurer Beobachtungen plausibel? Welche Maßnahmen würdet ihr noch empfehlen bzw. wo setzt ihr an, um Verluste des Core-3-Updates zu minimieren?

27 Gedanken zu „Google March Core Update 2019 – Was nun? (Seo-Campixx 2019)“

Der Beitrag hört sich ja an, als ob Du die Google suche, im Griff hast. Mich würde mal interessieren ob diese Maßnahmen tatsächlich etwas im Zeitraum von einem Jahr gebracht haben. Ich vermute mal das die Seitenaufrufe steigen werden, ob der Aufwand aber auch einen höheren Umsatz bringen wird? Ich denke die Einnahmen werden immer weiter im Keller gehen.

Hmm, wie meinst Du das „die Google-Suche im Griff“? Die bekannten Schwächen meiner Seiten habe ich oben hoffentlich deutlich beschrieben. Auf der Grundlage kann ich nun verbessern. Das mit den Einnahmen ist zweitrangig, solange es so viel ist, dass ich mich und meine Familie ernähren kann :-)

Erst gibt es eine Menge Vermutungen warum weniger Besucher kommen.

Was folgt daraus? Welche (SEO-)Maßnahmen?

Jetzt listest Du auf was Du machen willst, damit vermutlich wieder mehr Besucher kommen.

Die Frage ist, wenn Du alles für Googel machst, was Du vermutest, damit wieder mehr Besucher von Googel kommen, ob auch Googel die gleiche Vorstellung hat wie Du.

Ich meine, Du kannst aufwendige Blogbeiträge mit Vermutungen schreiben, die Umsätze werden trotzdem weiter zurückgehen. Ich denke, dass entscheidende wird sein, ob Seiten, die für Googel und Adsense gemacht werden, sich in Zukunft noch lohnen, den was bringen eventuell mehr Besucher, wenn am Monatsende immer weniger auf das eigene Konto kommt. Ich gehe davon aus, das Deine Webseiten durch die Werbung auch etwas einbringen sollen.

ach so … Naja, Google ist halt eine Trafficquelle von vielen. Noch ist diese Suchamschine das Tor ins Internet. Letztlich geht es natürlich um meine Artikel. Vielleicht kommt irgendwann das Bezahl-Internet – dann habe ich eine gute Grundlage.

Hallo Martin

Jüngere Webmaster könnten den Eindruck gewinnen, durch den Blogbeitrag mit Vermutungen, das man in kurzer Zeit mit ein paar Maßnahmen bei Google wieder gut gelistet ist.

Ich denke in der Realität sind auch bei Deinen Seiten, die Du hier vorgestellt hast immer weniger Umsätze erwirtschaftet worden.

Bezahlinternet? Wenn es bei der Wikipedia alles Umsonst gibt?

Ja, ABER…

Das Update ist meiner Meinung nach nicht durch. Hab am Anfang auch sehr viel verloren, das Spiel geht aber nicht nur auf meiner Seite weiter…

Onpage ist da bei bestimmten Seiten noch was rauszuholen, zB auch Daten zum User Verhalten was Google so mitbekommt.

Klar, da muss erstmal SEO Tee her, besser machen und warten.

Leider ist das so.

OBN ist dir doch nen Begriff oder? Hatte das auch erst in Verdacht.

Ich sehe bei mir eine Aufwärtsbewegung, die tatsächlich noch anhält oder gerade erst abschließt.

Allerdings kann ich schwer sagen, ob das an eigenen SEO-Maßnahmen liegt. Dummerweise habe ich genau in der Zeit vor dem Core-Update stark an mobilen Usability und Geschwindigkeit gearbeitet.

Oh, da sind wir schon 2. Also Pagespeed Optimierung, zb http2 und http2 Push hatte ich vorher auch durchgeführt.

Hallo Martin,

einige Dinge werden meiner Meinung nach nicht funktionieren.

1. Mehr Angebote: ich biete verschiedene Downloads etc. auf meiner Seite

An. Diese Unterseiten sind mit am härtesten bei mir betroffen.

2. Autorenboxen: im Prinzip eine gute Idee. Aber wenn das kein „trust“ Update

Update War, dürfte das nichts bringen.

3. Navi: ich habe eine Suche und breadcrumb Navi bei mir und dennoch massiv

Verloren.

Das mit dem Longtail kann ich allerdings bestätigen. Das mit dem ctr aus

aus den Serps heraus finde ich interessant. Das werde ich bei mir Evtl. Mal probieren

Gruss sascha

Zu 3.:

Möglich und recht wahrscheinlich ist doch aber auch, dass sich deine Seite von Martins unterscheidet. Vergleichen kannst du eigentlich nur direkt, wenn Seiten ähnlich aufgebaut sind und ein ähnliches SEO betreiben. Dann ließen sich Rankingverluste oder -gewinne besser interpretieren lassen. Heißt, wenn du eine Suche eingebunden hast und Breadcrumbs verwendest, aber dennoch verloren hast, muss das bei einer anderen Seite nicht zwangsläufig genau so sein. Dafür unterscheiden sich die Seiten sonst sicherlich zu stark. Da wirst du vielleicht an der ein oder anderen Stelle was falsch/gar nicht machen, was auf der Seite hier besser gelöst ist oder berücksichtigt wird. Kurzum: Nicht jede Seite mit Breadcrumbs und Suche wird verloren haben, weil es bei dir so war. Im Fall von Martins Seite könnten das auch genauso gut 2 sinnvolle Elemente sein, die bislang einfach gefehlt haben und nun dabei helfen könnten, wieder aufzusteigen oder die hätten helfen können, einen Absturz milder zu gestalten. Genauso kann man dann den 1. Punkt von dir bewerten: Vielleicht sind deine Download etc-Unterseiten ja auch einfach deshalb gesunken, weil sie schlecht sind und z.B. nicht Vertrauen beim Nutzer schaffen, du massenhaft Onpage-Fehler auf der Seite machst und mies intern verlinkst (nur Beispiele). Zu 2 von dir: Ja, selbst WENN es kein solches Update war, kann eine Autorenbox dennoch positive Signale senden und bei künftigen „Trust-Updates“ helfen, zu gewinnen oder mindestens nix zu verlieren ;-)

Aber auch das ist wiederum nur Spekulation, wie das eben meist ist: könnte, hätte, wäre … am Ende gilt testen, testen, testen und eigene Schlüsse aus solchen Starken Veränderungen zu ziehen, wie sie sich jetzt ergeben haben. Ich denke viele der von dir aufgezählten Punkte, Martin, gehen in die richtige Richtung. Und deine Auswertung gibt dir ja allen Anlass dazu, genau die Maßnahmen anzugehen!

Grüße Thomas

Eventuell könnte ein von Google kürzlich (am 12. März 2019) aktualisiertes Patent eine Auswirkung beim jetzigen Core Update haben:

„Modifying search result ranking based on implicit user feedback“

http://patft.uspto.gov/netacgi/nph-Parser?Sect1=PTO1&Sect2=HITOFF&d=PALL&p=1&u=%2Fnetahtml%2FPTO%2Fsrchnum.htm&r=1&f=G&l=50&s1=10,229,166.PN.&OS=PN/10,229,166&RS=PN/10,229,166

Es ist auf jeden Fall merkwürdig, dass das Patent genau in dem Zeitraum vom März Core Update aktualisiert wurde. Google kann ja messen, wie lange jemand auf der Seite bleibt, bis er zu den Google Serps zurückklickt.

Das Verhalten von Usern, d.h. Nutzersignale spielen inzwischen ggf. eine stärkere Rolle für das Ranking.

Interessantes Patent :) Genau das habe ich vor kurzem in der Debatte um dieses Update in Zusammenhang mit meiner Aussage, ToS alleine ist für sich genommen nichtssagend, anheim gestellt. Schade, dass ich bei der Diskussion dieses Patent nicht zur Hand hatte. Selbst in dem Patent ist aufgeführt, dass die Bandbreite der ToS eine zu hohe Bandbreite hat, um sie alleinig zu nutzen. Danke für das Teilen des Patents.

Hallo Martin,

du macht wirklich eine gute Arbeit. Ich lese deine Artikel schon lange und finde diese sehr interessant.

Einen Hinweis habe ich für Dich: Auf der mobilen Version deiner Seite ist KEIN Content above-the-fold. Die Seite sieht ohne scrollen wie folgt aus:

1. Logo

2. Menu (Ist zu groß für das Handy)

3. Cookie Warnung (Viel zu groß, sollte nach unten so klein wie möglich)

4. Adsense (na gut – jeder muss Geld verdienen)

5. KEIN Content

Ich habe natürlich keine Ahnung ob etwas davon zm Absturz geführt hat. Allgemein ist aber bekannt, dass der Content above-the-fold wichtig ist. Und inzwischen mobile first angesagt.

Grüße und Viel Erfolg!

Max

Ja, vielen Dank. Wirklich ein hilfreichen und wichtiger Hinweis. Wie beschrieben, prüfe ich viel zu wenig an Mobilgeräten. Ich bin aber schon dabei, das umzugestalten und den Datenschutz-Banner unten anzuzeigen und zu verkürzen.

Die Sache mit dem Anbieter schlägt Ratgeber, sehe ich auch. Und zwar massiv. Quasi als ob Google auch etwas gegen Nischenseiten unternehmen will, die nicht wirklich Ratgeber, sondern eher Vermittler sind.

Das geht, wie schon einmal erwähnt, sogar soweit, dass 2.000 Wörter starke, hochinteressante und wirklich gute Ratgeber auf Seite 2 stehen, während 500 Wörter lange Schwachsinnsartikel (!) von den Anbietern ganz oben ranken. Ein Blinder sieht dort, dass die Qualität der Informationen einfach Schrott ist und keinen Mehrwert bietet. Quasi generische Produktbeschreibung gegen holistischen Ratgeber.

Zum Rest weiß ich noch nichts. Aktuell schwanken viele Rankings in meinen SEO Tools wieder stark. Da rutschen die Plätze täglich um die fünf Plätze auf oder ab, die vorher über Monate stabil auf 1-3 standen.

Für wahrscheinlich halte ich also obere Theorie plus RankBrain. Ich glaube RankBrain hat mehr Macht bekommen und sortiert jetzt nach Nutzerverhalten bzw. einfach deutlich stärker als jemals zuvor. Vielleicht müssen wir uns auch einfach davon verabschieden, dass ein Ranking bestehen bleibt. Vielleicht läuft alles darauf hinaus, dass es jetzt ständige Wechsel, je nach Besucherverhalten gibt.

So oder so… finde deine Artikel dazu sehr interessant und die Diskussionen auch. Sowas regt immer gut den Geist an und fördert die Gedankenspiele. Und da kaum etwas bestätigt ist, ist das ja alles in bisschen wie theoretische Physik.

Hallo Martin,

zur kurzen Beobachtung, also von deinen und meinen Seiten… es geht tatsächlich weiter in der Abwärtsspirale.

Ich habe nun, und das haben wir gemeinsam, die meisten externen Links auf Nofollow gesetzt. Es scheint ein OBN bzw PBN Problem zu sein.

Also selbst “ Empfehlungen “ zu eigenen Seiten, wenn die Follow sind.

Bei mir hat es auch einen „Vertrauensbonus“ gegeben, also zu Keys die gar nicht auf der Seite vorkamen rankten. Vermutlich steckt jetzt irgend ne KI dahinter, die die Google Quality Rater Guidelines nun von Menschlichem Input nutzt.

Aber auch das ist einfach eine Vermutung.

Ich weiß ja nicht, aber ich glaube ihr interpretiert hier mal wieder sehr viel rein. User-Intention, User-Signals, RankBrain, … am Ende ist es vielleicht ganz einfach.

Bei mir sind vor allem die älteren Seiten (5 Jahre +) mit starken Links und klarem Themenfokus wieder nach oben geklettert – vor allem im Shorthead. An denen hab ich in letzter Zeit nichts verändert, nichts optimiert, keine neuen Links aufgebaut, keinen/wenig neuen Content erstellt.

Das Einzige, was hier zählen könnte, sind IMHO die alten themenrelevanten Links, die schon länger Bestand haben.

Sehe ich auch so.

Google hat mit diesem Update (und mit Medic) an Linkschrauben gedreht. Meiner Beobachtung nach gibt’s diese drei Möglichkeiten (eventuell in Kombination):

– Für Shorthead Keywords wurden externe Links wieder stärker gewichtet, eventuell abhängig von der Quelle.

– Änderung in der Linkkraftverteilung, sodass externe Links in erster Linie die Zielseite stärken und andere Seiten nicht mehr ganz so gut rankbar sind – insbesondere für Shorthead Keywords.

– Penguin wurde abgeschwächt.

Für Google sind Links = Trust. Alles andere, vonwegen Autoreninformation etc. ist irrelevant. Das einzige was zählt sind Links. Die einzige zuverlässige Möglichkeit wie Google sicherstellen kann, dass YMYL-Seiten von Experten geschrieben werden, sind Links von anderen YMYL-Seiten. Je mehr, desto besser.

Diese Bewertung gilt nicht nur für YMYL, sondern für alle. Der Grund wieso YMYL offenbar stärker betroffen waren (Stichwort Medic) liegt eventuell einfach darin, dass viele YMYL-Themen im Shorthead besonders stark umkämpft sind und sich die Neubewertung der Links scheinbar stärker auswirkt als sonstwo.

Wenn der Linkspam wieder überhand nimmt, wird Google die Schraube wieder ein wenig zurückdrehen.

Hallo Martin,

super Artikel, mir hat das mit den Breadcrumbs weitergeholfen, die hatte ich tatsächlich noch nicht integriert.Ich hatte bei einigen meiner Seiten auch ein starkes down mit anschließendem langsamen up festgestellt. Das sieht mir dann wirklich nach einem lernenden Algorithmus aus, zumindest kann ich ich mir das sonst nicht anders herleiten.

Interessant wären auch Artikel wo du Rankingveränderungen nach deinen Änderungen überprüfst :).

Viele Grüße

Christian

Was mich interessiert. Auf Blutwert hast du nun eine Autorenbox… nutzt du dieselbe Box jetzt auf allen Seiten? Weil das wäre ja dann wieder kopierter Content. Auf der anderen Seite ist es völlig bekloppt, mehrere Autorenbeschreibungen zu verfassen, schließlich versucht man ja einen möglichst perfekten Text zu schreiben und kann nicht fünf verschiedene Autorenboxen erschaffen, die alle perfekt sind.

bin noch nicht sicher, ob ich das überall einsetzen werde. Aber, wenn, dann sehr ähnlich. Duplicate Content nur als „echte Kopie“ aufzufassen halte ich jedoch für veraltet. Wenn ein Text im Grund das gleiche aussagt, nur eben mit anderen Worten, dann ist das auch DuplicateContent – nach meinem Verständnis.

Erst mal will ich aber beobachten, wie sich das entwickelt. Ich glaube inzwischen immer weniger, dass es mit „Expertise“ zu tun hat.

Also die letzten 4-5 Tage sind meine Besucherzahlen und Linkposition aber wieder fast an alter Stelle also von 105000 runter auf 8000, vorher waren es 7000 (seit Herbst 2018), davor waren es 9000. Das Google unser Forum mal was gutes will, hat aber noch nie lange angehalten. Es wieder immer wieder alles zurück geschraubt, weil irgend welche wichtigen Leute aufschreien, dass sie zu viel verloren haben. ^^

Kommentare sind geschlossen.