Wie funktioniert der Google Bildersuche-safeSearch-Filter?

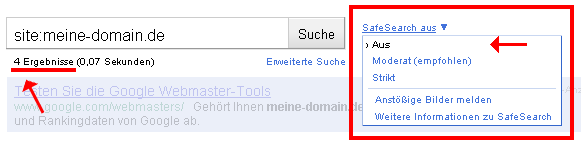

Dieser Artikel beschäftigt sich mit dem „safeSearch-Filter“ der Google Bildersuche. Es ist der zweite Teil einer kleinen Serie über den SafeSearch-Filter (siehe „Google Bildersuche: in den safeSearch-Filter und wieder heraus„). Die Google Bildersuche besitzt – wie übrigens auch die Videosuche – eine Filteroption. Damit lassen sich die Ergebnisse in drei Kategorien anzeigen. Die erste Möglichkeit ist „ungefiltert“. Bei Google heißt das „SafeSearch Aus“. In dieser Ansicht werden alle gefunden Ergebnisse angezeigt, egal, wie schmuddelig sie auch sein mögen.

Per default ist die Bildersuche auf „Moderat“ eingestellt. Die meisten Google-Benutzer werden die Filtereinstellung überhaupt nicht kennen oder nutzen. Man kann die „Moderate Filterung“ daher auch als die „normale Bildersuche“ bezeichnen. Im Unterschied zur Bildersuche ohne safeSearch werden eine Reihe von Bildern durch den Filter herausgefischt: eben all diejenigen, die irgendwie „anstößig“ sind – bzw: die Google für „anstößig“ hält. Noch mehr Bilder werden heraus gefiltert, wenn man die SafeSearch-Einstellung auf „Strikt“ umschaltet. Dann sollten eigentlich nur solche Bilder übrig bleiben, die keinerlei bedenkliche Inhalte zeigen. Google empfiehlt die „Strikt“-Variante zum Beispiel, wenn Kinder in der Bildersuche surfen.

Hier die Seite von Google, die den SafeSearch-Filter beschreibt.

Die meisten suchen mit „moderater SafeSearch“

Wie gesagt: man kann davon ausgehen, dass der größte Teil der Google-Bildersuche-Benutzer in der Standard-Einstellung „Moderat“ sucht. Wenn man eine Website mit vielen Bildern hat, und eine Reihe dieser Bilder in der Bildersuche gut platziert sind, dann kann man eine Menge Besucher über die Google Bildersuche erhalten.

Wie gestern beschrieben, ist eine meiner Domains in den Filter gerutscht. Die Bilder, die vorher (fast) alle in der moderaten Bildersuche zu finden waren, sind in dieser Zeit nur in der Bildersuche angezeigt worden, wenn man den SafeSearch-filter auf „Aus“ geschaltet hat. Ich habe mal nachgeschaut: in dieser Zeit habe ich fast überhaupt keine Besucher über die Bildersuche bekommen. Der Anteil derjenigen, die mit „SafeSearch-Aus“ gesucht haben, war praktisch gleich null. Das ist auch logisch. Wenn man den Filter ausschaltet, sucht man vermutlich nicht nach Weihnachtsmann oder Jack Sparrow.

Wer also eine „normale“ Website mit „normalen“ Bildern betreibt, für den ist es zwingend notwendig, in der moderaten Bildersuche gelistet zu sein. Alles andere ist für die Katz.

Nach dem, was ich in den letzten Tagen recherchiert habe, kommt es gar nicht so selten vor, dass Bilder in den Filter geraten. Nur bemerken es viele vermutlich überhaupt nicht. In meinem Fall kommen ca. 70% der Besucher über die Google Bildersuche – da fällt es auf. Aber viele andere haben vielleicht noch gar nicht bemerkt, welches Potential ihnen verloren geht.

Wie kann man erkennen, ob an im Filter hängt?

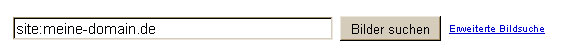

Wie kann man das prüfen? Ganz einfach: mit der Site-Abfrage. Einfach nach Folgendem suchen:

Zunächst muss man in der „moderaten Bildersuche“ nachschauen, wie viele Bilder angezeigt werden. Und dann den Filter ausschalten: Wie viele Bilder werden nun angezeigt?

Wenn beide Zahlen identisch sind, hat man kein Problem. Wenn sie allerdings abweichen, und in der moderaten Bildersuche weniger Bilder angezeigt werden, ist das ein klarer Hinweis, das ein Teil der Bilder heraus gefiltert werden. Wenn ihr das beobachtet, postet es doch mal in den Kommentaren.

Aber wie kann es nun dazu kommen, dass einzelne Bilder oder sogar eine komplette Domain in den Filter geraten?

Wie funktioniert der Bildersuche-SafeSearch-Filter?

Jetzt wird es spekulativ. Denn Google gibt dazu keinerlei Hinweise. Aufgrund welcher Methoden und Funktionen und Kriterien werden Bilder von Google ausgefiltert? Ich versuche es mal systematisch – Welche Merkmale kann Google überhaupt herausziehen?

- Analyse des Bildmaterials

- Analyse des Dateinamens

- Analyse des Textes, der dem Bild zugeordnet wird, bzw. der Seite, auf der das Bild erscheint

- Analyse der Links (eingehende und ausgehende)

- Benutzer-Meldungen über anstößigen Inhalt

1. SafeSearch-Filter: „echte“ Bildanalyse

Der erste Punkt „Analyse des Bildmaterials“ ist sicherlich der einfachste. Natürlich gibt es mittlerweile eine Menge Algorithmen, die Bilder analysieren können. Die sind inzwischen weit verbreitet. Als Beispiel sei die automatische Gesichtserkennung genannt, die heutzutage praktisch in jeder Digitalkamera funktioniert. Google selber bietet mit „Similar Images“ (Ähnliche Bilder) eine Funktion an, die offensichtlich auf der Auswertung von Bildinformationen herrührt. Allerdings: so gut das zum Teil auch funktioniert – es ist und bleibt hochgradig fehlerbehaftet. Ein Fahrrad von der Seite ist sehr einfach zu ermitteln. Aber ein Fahrrad von vorn ist schon viel komplizierter.

Der Haupt-Einsatz der echten „Bildanalyse“ ist sicherlich in „stereotypen Bildmustern“ im Porno oder Waffen- (Gewalt-) Bereich zu suchen. Hier können vorher definierte Bildmerkmale relativ leicht ermittelt werden.

Die Bildanalyse bleibt jedoch unscharf. NerdInSkirt konnte vor einiger Zeit zum Beispiel nachweisen, dass Akt-Fotos in Schwarz-Weiß nicht herausgefiltert werden, wenn der Dateiname und der umgebende Text vollkommen harmlos sind (siehe „Google Image Search: Bad Neighbourhood„).

2.SafeSearch-Filter: Analyse des Bild-Dateinamens

Wie bei der Optimierung von Bildern sind auch bei der Google-Analyse von Bildern die Textinformationen die wichtigste Informationsquelle. Dabei spielen sicherlich alle verfügbaren Texte, eventuell in unterschiedlicher Gewichtung, eine Rolle. Zentral ist vermutlich der Dateiname: ein Bild mit dem Titel „explicite-hardcore-p***.jpg“ (ich schreib es aufgrund schlechter Erfahrung nicht mehr aus ;-) ) hat vermutlich relativ gute Chancen, sofort heraus gefiltert zu werden.

3. SafeSearch-Filter: Analyse der Texte

Google weiß natürlich auch, dass der überwiegende Teil der Bilder keine tatsächlich beschreibenden Dateinamen hat. Im Gegenteil, nur allzu oft werden nach wie vor nur kryptischen Zahlen und Buchstabenkolonnen (aus der Digitalkamera oder einen schlechten CMS benutzt).

Daher spielt neben dem Dateinamen der umgebende Text und der Titel der Website eine wichtige Rolle. Google ist mittlerweile recht gut darin, diese Texte semantisch zu prüfen. Zumindest, wenn es darum geht, bestimmte Inhalte zu entdecken. Ein anstößiger Text wird aufgrund der verwendeten Begriffe und Phrasen relativ leicht zu ermitteln sein.

Und genau hier liegt die Gefahr für normale Websites. Denn möglicherweise interpretiert der Filter-Algorithmus einen Text, in dem bestimmte Begriffe vorkommen, eben falsch. Dazu später mehr…

4. SafeSearch-Filter: Analyse der Links

Relativ einfach ist die Sache mit den Links: wenn eine Seite von „kritischen“ Seiten Links bekommt (Bad Neighborhood), schweben die Bilder in höchster Gefahr. Und wenn die Bilder sogar auf solchen Seiten gehotlinkt werden, noch mehr. Es ist, wie gesagt, spekulativ und nicht getestet, aber ich denke, man kann Bilder von einer kritischen Seite aus rauskegeln. Indem man eben harmlose Bilder in einem anstößigen Kontext als Hotlinks zeigt.

Der zweite Punkt hierbei sind sicherlich die ausgehenden Links: wenn von einer Seite zu (aus Google-Sicht) eindeutig anstößigen Websites verlinkt wird, dann ist das sicherlich für die Bilder auf der Seite problematisch.

5. SafeSearch-Filter durch Benutzermeldungen

Dieser Punkt ist mir ziemlich unklar. Was passiert, wenn Benutzer ein Bild als anstößig melden? Natürlich kann man im ersten Moment denken, dass das Bild dann sofort in der „moderaten Bildersuche“ gesperrt würde. Aber wie so oft wäre das zu einfach. Denn dann könnte ja jemand ohne Probleme die gesamte Konkurrenz abräumen, bis das eigene Bild auf Pos. 1 rankt. Nein, die Benutzermeldungen sind vermutlich nur ein Indiz. Möglicherweise wird ab einer bestimmten Menge von Benutzermeldungen ein Bild automatisch rausgeworfen. Oder das Bild wird tatsächlich manuell von einem Google Mitarbeiter überprüft? Möglicherweise hat der Filter auch mehrere „Stufen“, und je mehr Meldungen eintrudeln, umso kritischer prüft er die übrigen Signale.

Wenn man sich mal die offizielle Melde-Seite bei Google anschaut. liegt die Vermutung nahe, dass die Bilder manuell geprüft werden.

Was sagt Google selber?

Im Folgenden die Passage aus der Google-Website über die „Sucheinstellungen“ (Absatz „SafeSearch-Filter„):

Viele Nutzer möchten nicht, dass Websites mit nicht jugendfreien Inhalten in ihren Suchergebnissen angezeigt werden, insbesondere, wenn der gleiche Computer auch von Kindern genutzt wird. SafeSearch von Google filtert Websites, die ausdrücklich sexuellen Content enthalten, und entfernt diese aus Ihren Suchergebnissen. Kein Filter ist zu 100 Prozent genau, jedoch sollte SafeSearch nahezu alle unangemessenen Inhalte und Materialien filtern.

Aha. Nicht 100 prozentig, aber alle unangemessenen raus. Anders formuliert: der Filter ist im Zweifelsfall etwas zu „scharf“ eingestellt. Dadurch fliegen mit großer Wahrscheinlichkeit alle anstößigen Bilder raus. Nur leider kommt es dabei zu kleinen Kollateral-Schäden: Ab und zu fliegen eben auch mal ein paar „nicht-anstößige Bilder“ mit heraus.

Welche Bilder-„Strafen“ gibt es?

Ich habe bislang zwei Varianten beobachtet. Wobei die zweite nur eine verzögerte Auswirkung der ersten sein könnte. Sicher ist, dass eine komplette Domain, das heißt alle Bilder, die dieser Domain zugeordnet werden, in den Bildersuche-Filter gelangen kann. Das habe ich gerade erlebt (siehe Bericht von gestern).

Die zweite Möglichkeit ist, dass nur einzelne Bilder bzw. Bildergruppen in einen Filter rutschen können. Einzelne Bilder bedeutet, dass alle übrigen Bilder einer Domain nicht betroffen sind. Bildergruppen sind nach meinen (zugegeben alten) Beobachtungen innerhalb eines Ordners zu finden. Soll heißen: es können auch nur diejenigen Bilder, die in einem bestimmten Ordner liegen, aussortiert werden und alle übrigen sind nach wie vor in der „moderaten Bildersuche“ zu finden. Wie gesagt: das sind relativ alte Beobachtungen. Eventuell war die Bildersuche damals noch so träge, dass sich das ganze Ausmaß der Katastrophe gar nicht entfalten konnte, weil ich die Texte zügig wieder angepasst habe. Wenn hier jemand etwas entdeckt oder über eigene Beobachtungen berichten kann, würde ich mich freuen.

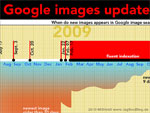

Herausgefilterte Bilder bleiben trotzdem in der Bildersuche

An dieser Stelle eine kurze, interessante Beobachtung: wie beschrieben, wurde meine Domain komplett aus der moderaten Bildersuche verbannt. Allerdings – und das ist erstaunlich – nur die Domain bzw. die Seiten. Die Bilder blieben in den allermeisten Fällen in der moderaten Bildersuche weiter sichtbar. Warum? Weil es eben viele Kopien oder Hotlinks von vielen meiner Bildern gibt. Obwohl Google Bild-Kopien unter einer ID laufen lässt, werden die (scheinbar) kritischen Bilder nicht entfernt. Google ändert dann einfach das Linkziel in der Bildersuche. Ingo „Putzlowitsch“ hat das auch schon einmal erlebt und beschrieben: „Alles für die Katz„.

Vielleicht ist es ein Bug. Aber ich vermute eher, dass man daraus etwas ableiten kann: Google kritisiert gar nicht die Bilder, sondern den Kontext. Wenn es um das Bild an sich ginge (weil es z.B. durch die „echte Bildanalyse“ als anstößig interpretiert wurde), dann würde es sicherlich als Information an die Bild-ID geheftet. Dann müssten auch alle Kopien aus der moderaten Bildersuche verschwinden. In meinem Fall war das nicht der Fall.

Hauptproblem: falsch verstandener Text

Die Ursache für das Verschwinden von harmlosen Bildern ist sicherlich in aller Regel im umgebenden Text zu suchen. Google bemängelt nicht die Bilder, sondern den Text der jeweiligen Seite. Für mich ergibt sich daraus, dass meine Bilder nicht als „anstößig“ gemeldet wurden, sondern dass ich beim Text Fehler gemacht habe.

Nun ist es allerdings nicht nur einen Seite. bzw. ein Bild, das verschwunden ist, sondern alle. Daher vermute ich weiter, dass es nicht um eine konkrete Textpassage ging, sondern um die „Gesamtheit der Texte“ auf dieser Domain. Ich habe vermutlich an zu vielen Stellen schlüpfrige Formulieren benutzt. Das führte dazu, dass eine „kritische“ Hürde gerissen wurde, was wiederum die gesamte Domain in einen anstößigen Kontext brachte. Und in der Folge hat Google vorsorglich mal alle Bilder aus dem Index gekegelt. Wie gesagt: alles spekulativ im Nebel herum gestochert, aber aus meiner Sicht plausibel…

Warum werden die Bilder bestraft, nicht die Seite?

Die große Frage bleibt: wenn Google aus seiner Sicht fragwürdigen Text findet, warum fliegen dann die Bilder aus der Bildersuche und nicht die Seite aus der organischen Websuche. Eines ist klar: keine Seite hat in der organischen Suche auch nur eine Position eingebüßt. …?

Dieser Artikel ist der zweite Teil einer dreiteiligen Serie.

- Google Bildersuche: rein in den Filter, raus aus dem Filter (Konkrete Fall-Beschreibung)

- Wie funktioniert der Google Bildersuche-safeSearch-Filter? (Dieser Artikel)

- Was tun, wenn Bilder im Google SafeSearch-Filter sind? (Themen: Wie kommt man wieder aus dem Filter heraus? Was sollte man überprüfen? An wen kann man sich wenden? Wie entwickelt es sich, wenn die Bilder wieder heraus sind?)

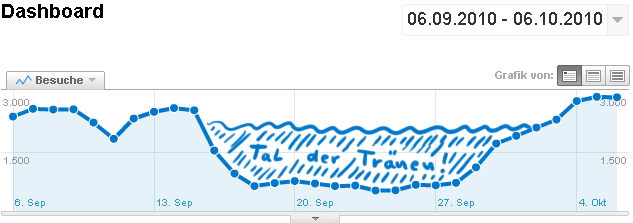

Im nächsten Artikel geht es dann um die Frage, wie man wieder aus dem SafeSearch-Filter der Google Bildersuche heraus kommen kann. Und dass die Maßnahmen, die man dafür umsetzen muss, der Seite sogar nützen können. Zumindest sieht das in meiner aktuellen Analytics-Statistik so aus:

17 Gedanken zu „Wie funktioniert der Google Bildersuche-safeSearch-Filter?“

Ich denke auch, das eine echte Bildinhalts-Bewertung derzeit nur eine untergeordnete Rolle spielt. Der Text dürfte mit das Hauptausschlußkriterium sein.

Etwas rätselhaft ist für mich aber immer noch der Fall mit meinen braunen Champignons. Ich denke, daß der Safesearch-Filter nicht nur auf die gemeinhin anstößigen Sachen anspringt, sondern möglicherweise auch auf andere Dinge, die nicht angezeigt werden dürfen oder sollen.

Danke für den Artikel. Ich sehe auf meiner kleinen Seite einen doch recht interessanten Unterschied: Mit dem Filter „aus“ werden 194 Ergebnisse gefunden, bei der Normaleinstellung „mittel“ sind es 186 Ergebnisse während bei „strikt“ überhaupt keine Ergebnisse gefunden werden.

http://www.google.de/images?hl=de&source=imghp&q=site:www.webanhalter.de

Und ich denke nicht, dass auf der Seite Inhalte vorkommen, die in irgendeiner Form jugendgefährend sind. Sodass ich gerade bei „strikt“ diese Filterung nicht nachvollziehen kann.

@Ingo: vielleicht ist das ein Nazi-Kosename ;-) Aber stimmt schon. Welche Phrasen Google nicht gefallen, ist ziemlich schwierig zu ermitteln. Dazu morgen mehr…

@Marc: ja, die Sache mit dem „Strikt“ ist noch ein Sonderfall. Ich habe das aus Platzgründen hier bewusst nicht weiter thematisiert…

Hallo,

weiß man das auch. Du musst mit einer anderen Domain mal testen, wie viele Meldungen es braucht um ein Bild `verschwinden´ zu lassen…

Grüße

Gretus

Interessante beobachtungen, danke dafür.

Über die Bad Neighbourhood könnte man die Konkurrenz ja aber auch recht leicht rauskicken, oder nicht? Ich denke nicht, dass dieses Kriterium daher eine Allzugroße Rolle spielt.

Hallo.

Gibt es im Zusammenhang mit der safeSearch-Filterung Erfahrungen oder Experimente mit der ICRA-Kennzeichnung?

Wäre mal von Interesse, in wie weit und ob überhaupt Google sich von deren Labels beeinflussen lässt.

Über Google lässt sich dahingehend nichts finden. ICRA scheint generell in Deutschland recht unbekannt …?

Der Artikel ist veraltet. Google läßt nun weltweit nur noch Moderate SafeSearch zu. „Aus“ gibt es nur noch bei Bing. Endlich ein handfester Grund zu wechseln. Nicht nur, daß Google nanny spielt, sie hören uns auch noch ab… pfff.

Die Frage ist, was tun:

Ohne den neuen Filter SafeSearch werden über 100 Fotos von meiner Website angezeigt.

Mit Filter: kein Einziges!

Nur Landschaftsfotos, Technik, Architektur, Portraits, Produktfotos, …

Nicht annähernd was „Anstößiges“ dabei.

Die Kommentare sind geschlossen.